※アクセス制限あり

[Japanese/English]

|

Movie Theater

公開開始: Jun. 12, 2013

Last updated: May. 9, 2018

|

研究成果,および研究室所属の学部生による実習制作作品に関する動画を Youtube で公開しています.各画像をクリックすると Youtube で動画を再生します. |

新着動画

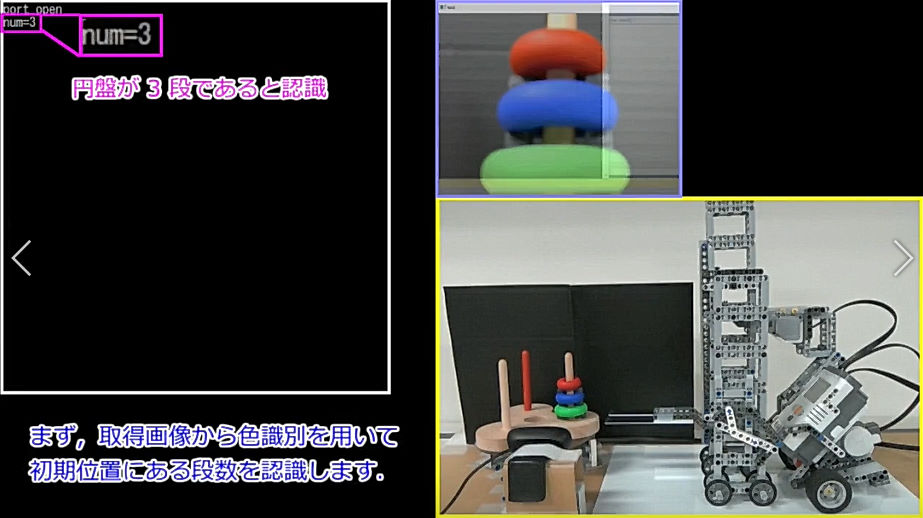

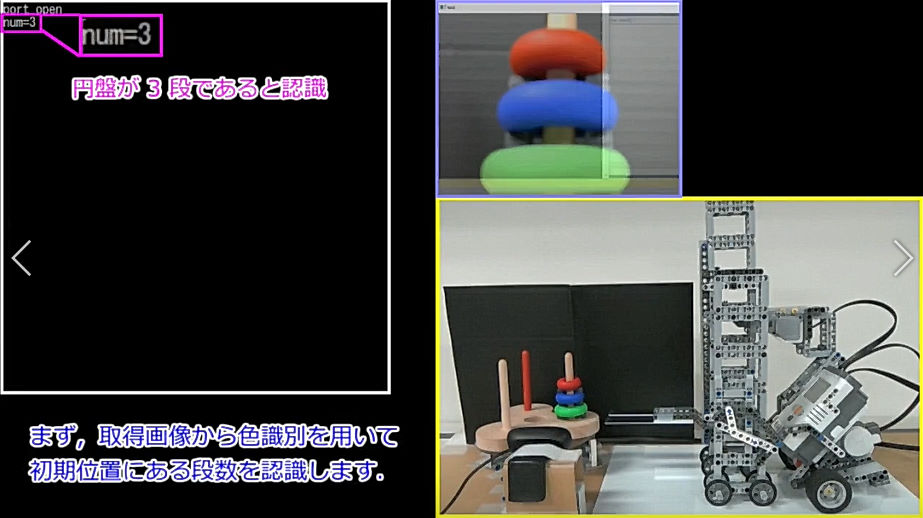

| 「ハノイの塔」の攻略 |

モーションキャプチャを用いた自動車遠隔操作システム |

ロボットによる商品の袋詰め作業支援システム |

音声認識とYOLOを用いた商品探索システムの開発 |

|

|

|

|

| ROSを用いたロボット制御による積み木の自動組み立てシステム |

SRGAN を用いた動画像の高解像度化 |

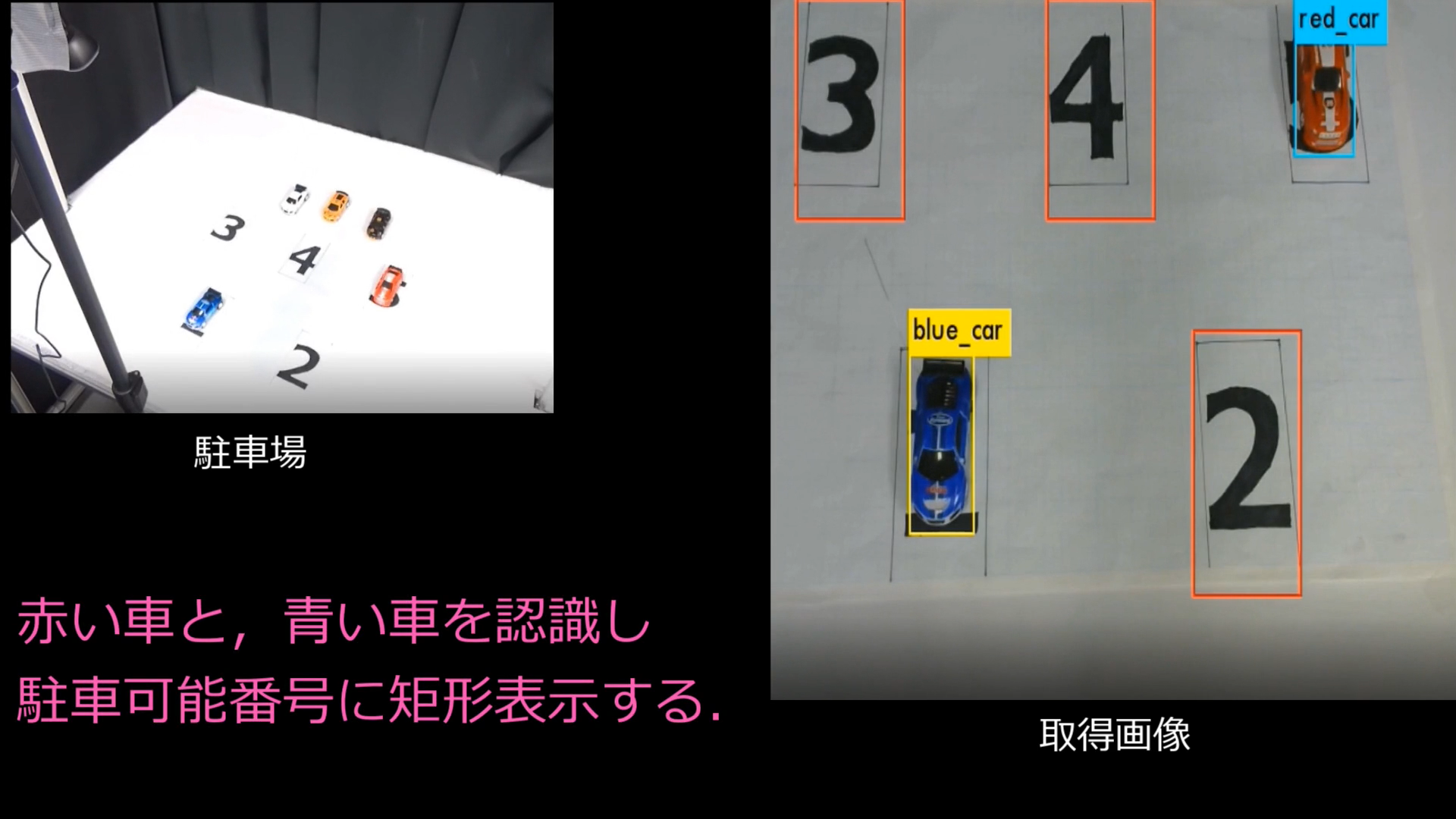

駐車場の空きスペース通知システム |

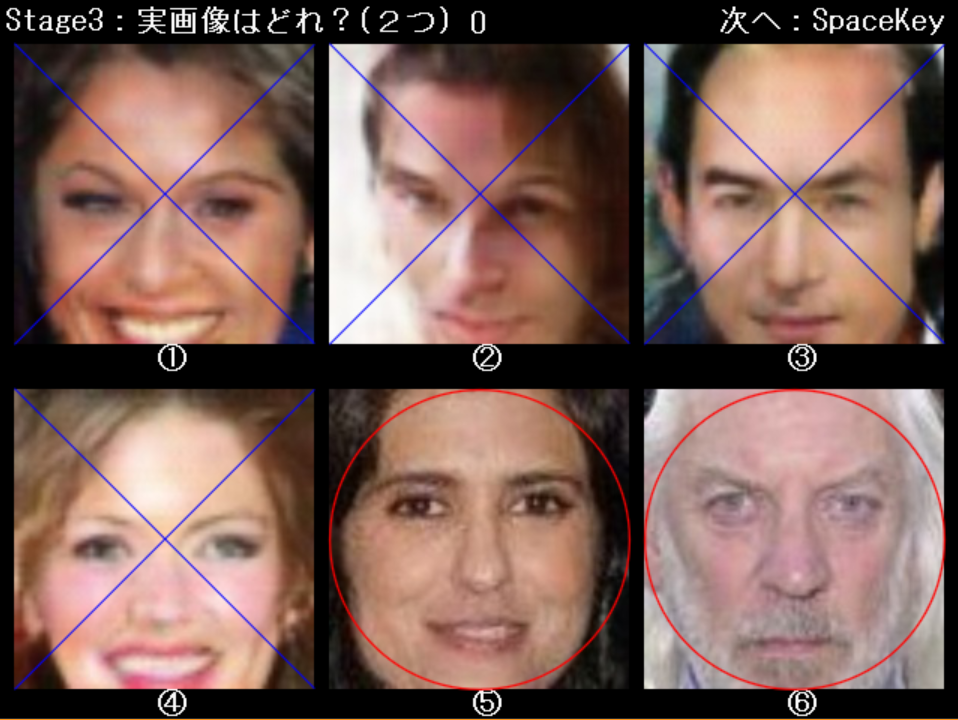

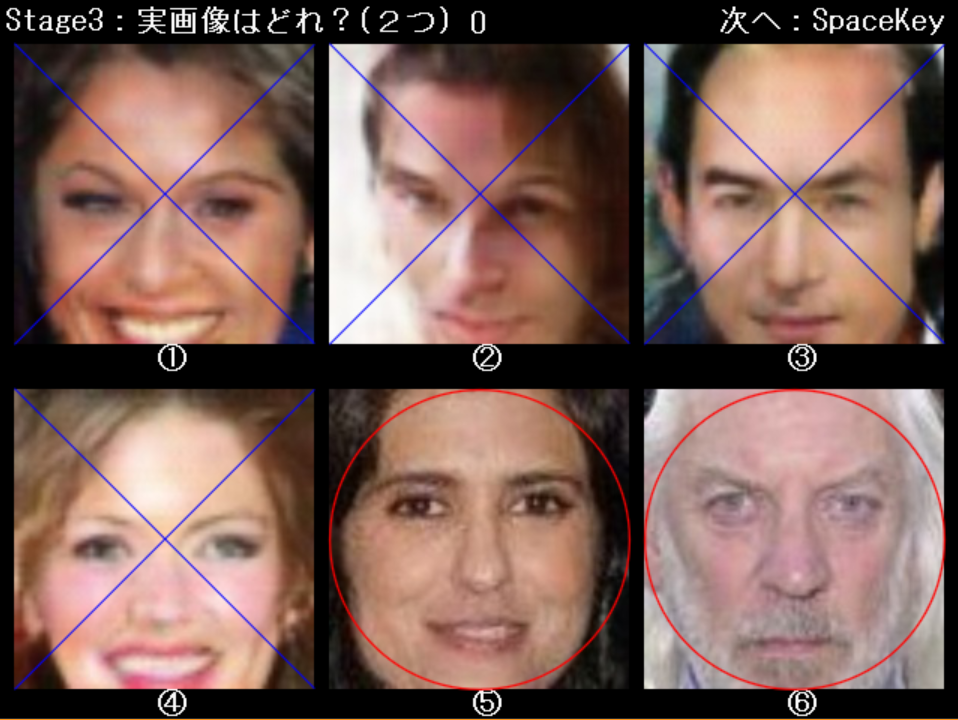

DCGAN による画像生成を用いた真贋判定ゲームの開発 |

|

|

|

|

|

研究成果デモ動画

|

橋本研究室では,3次元センシング,画像センシング,ヒューマンセンシングの3つの研究領域において,先進的かつ実用的な研究を行っています.

ここでは,学会発表等で紹介したデモや実験に関する動画を公開しています. |

3次元センシング技術

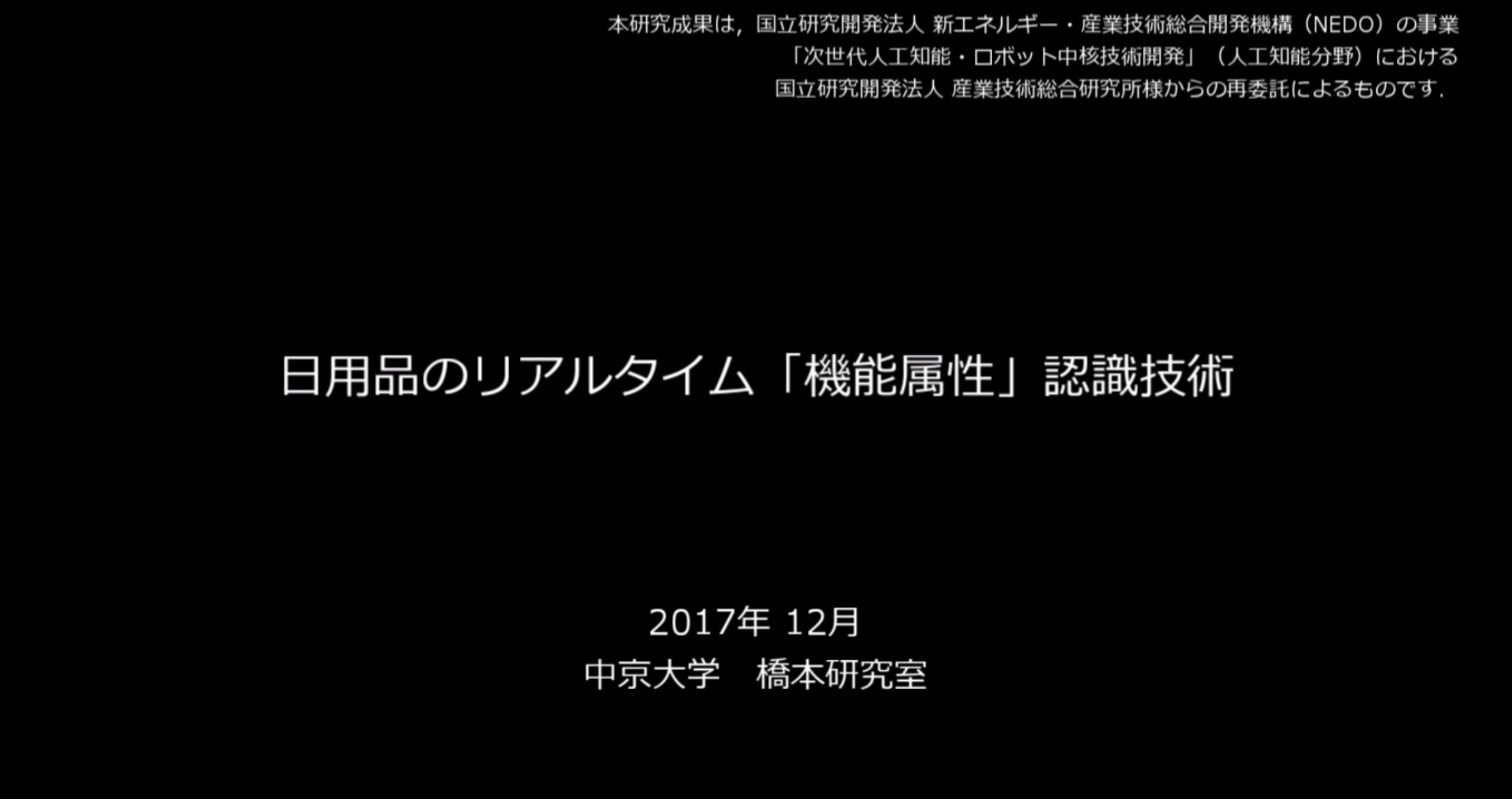

NEDOリアルタイム

機能属性認識

2017Dec(中京大学) |

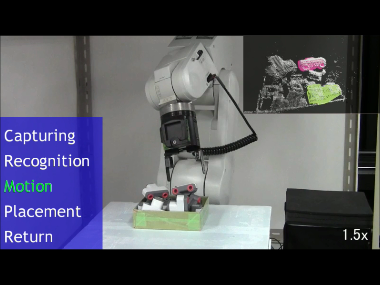

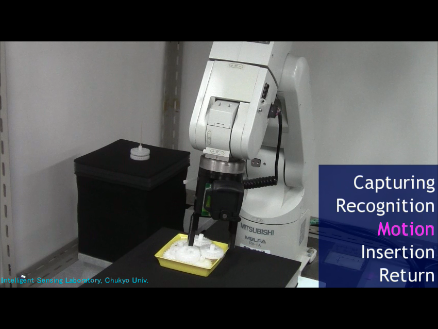

機能属性認識と

一般物体認識を利用した

生活支援ロボットの

プロトタイプ

(NEDOプロジェクト成果) |

Global Reference Frame

によるリアルタイム

6DoF 認識 |

可観測性を考慮した

ベクトルペアによる3次元位置姿勢認識と

部品ピッキング |

|

|

|

|

| 日用品のリアルタイム「機能属性」認識技術です. |

「コップにジュースをいれて持ってきて」 のような人の音声指令を理解して動作する,生活支援ロボットのプロトシステムを作成しました.【表彰】IMEC 2017 優秀講演賞 |

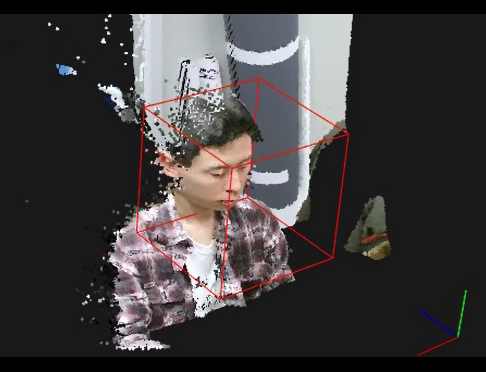

平面的な見え方の物体に有効な3DオリエンテーションであるGRFを考案し,6自由度姿勢追跡に応用しました.【表彰】iMec2014優秀講演賞 |

シーン中で安定的に観測可能であることと,特徴ベクトルの独自性が高いことを条件として選択した3次元特徴点を用いて物体の位置姿勢を認識します. |

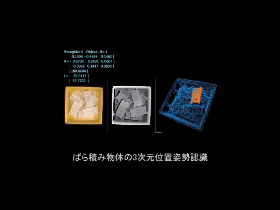

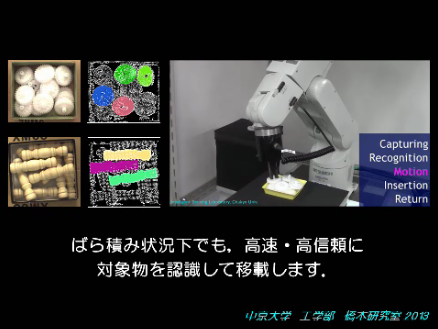

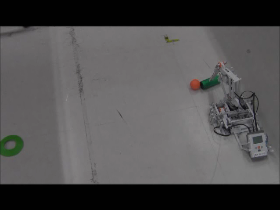

ばら積み部品の

自動認識システム |

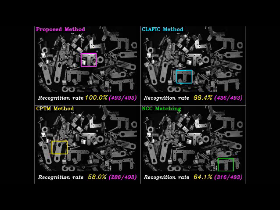

最適ベクトルベアを

用いた物体認識 |

|

|

ばら積み物体の位置姿勢を高信頼かつ高速に推定し,ピッキングするシステムを開発しました.【表彰】SSII

2012優秀学術賞他1件 |

ばら積みシーンの生成学習による高信頼な3次元物体認識です.認識した対象物をオレンジ色で表示しています.【表彰】DIA2013研究奨励 他1件 |

|

画像センシング技術

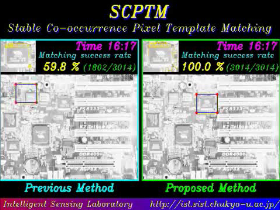

周辺類似物との

識別性能が高い

テンプレートマッチング |

照明変動に頑健な

テンプレートマッチング |

画像間共起確率に

基づく照明変動に

強い物体検出 |

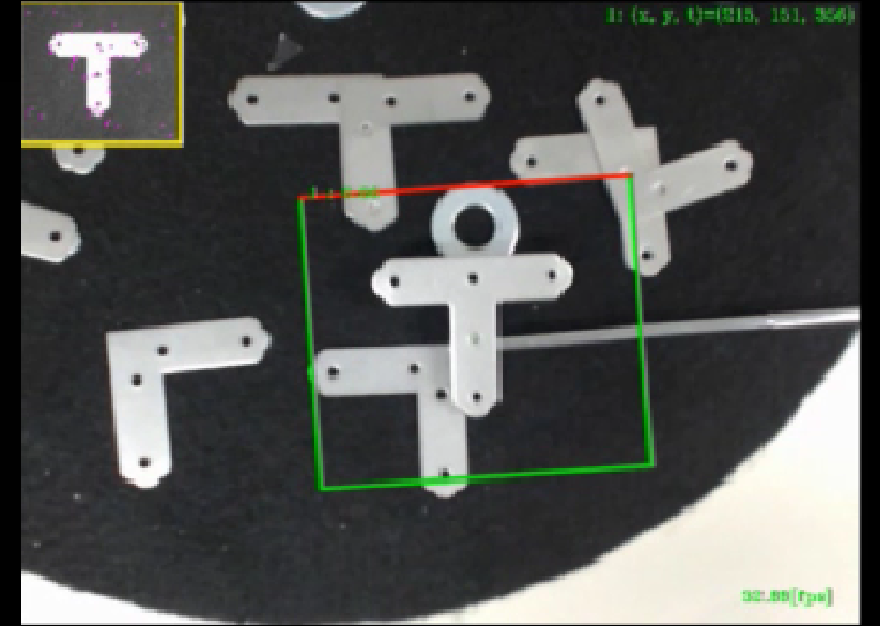

画素ペア学習を用いた

部品認識システム |

|

|

|

|

| DPTMのリアルタイムデモを,画像センシングシンポジウム(SSII 2013)にて展示しました.【表彰】DIA2012研究奨励賞他1件 |

SCPTMのリアルタイムデモを,画像センシングシンポジウム(SSII 2013)にて展示しました.【表彰】第12回CVIM卒論セッション優秀賞他3件 |

画素の時間的安定性を

考慮したマッチング手法(SCPTM )を大きな照明変動が含まれる画像群に適用しました. |

周辺物との識別性能を考慮した画素選択型テンプレートマッチング(DPTM)

です. |

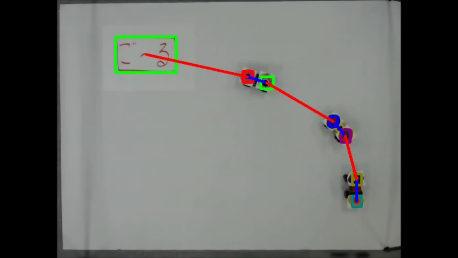

サブトラッカの

最適配置に基づく

オクルージョンに強い

物体追跡 |

濃度共起確率に基づく

ユニーク画素を用いた

超高速テンプレート

マッチング(CPTM) |

|

|

| 最適選択されたサブトラッカ群を用いた,オクルージョンに強い物体追跡です.青枠がサブトラッカです. |

テンプレート画像を分析して,マッチングに使用する画素数を大幅に削減します.従来手法の100~1000倍程度の高速化が可能です.【表彰】第14回PRMUアルゴリズムコンテスト優秀賞 |

|

ヒューマンセンシング技術

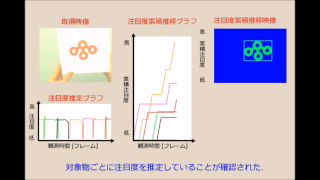

満足度推定のための

注目度・笑顔度

センシングシステム |

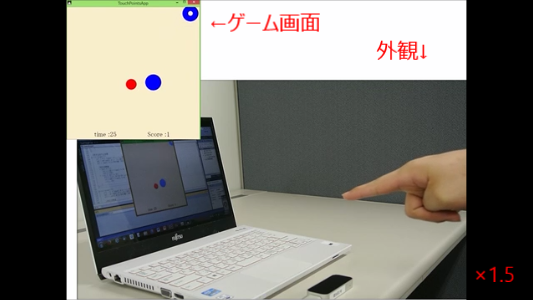

ユーザーの感性を

反映した商品設計

支援システム(試作) |

一人称視点カメラを

用いた対象物に対する

ユーザの注目度推定手法 |

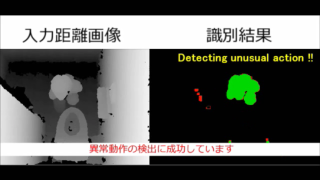

トイレ空間における

人間の非定常動作検出 |

|

|

|

|

| メガネ型カメラを用いた対象物に対する注目度と,固定カメラを用いた対象物を観測している時の笑顔度を推定する手法を開発した. |

物体に対する感性指標を自動で推定する手法を用いて,3次元物体モデルの検索システムおよび形状を修正するシステムを試作した. |

一人称視点カメラから取得した動画を分析し,対象物に対するユーザーの注目度を推定します. |

トイレ空間内における人間の動作を高信頼に識別することにより,非定常な動作(うずくまり動作)を自動で検出します. |

顔キーポイント特徴の

移動方向コードに基づく

個人依存しにくい

喜び表情識別 |

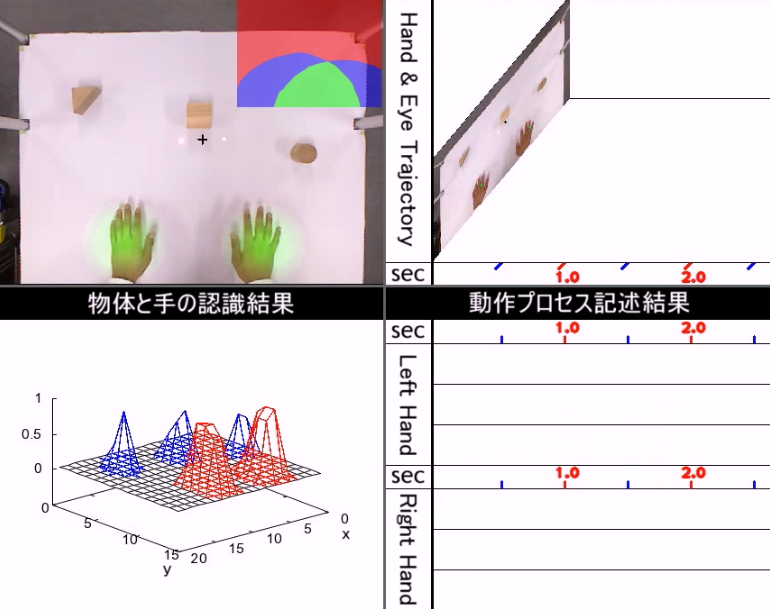

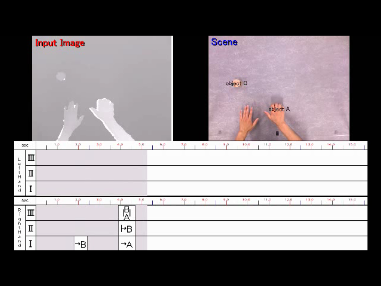

組み立て作業における

手動作と視線情報の

自動記録システム |

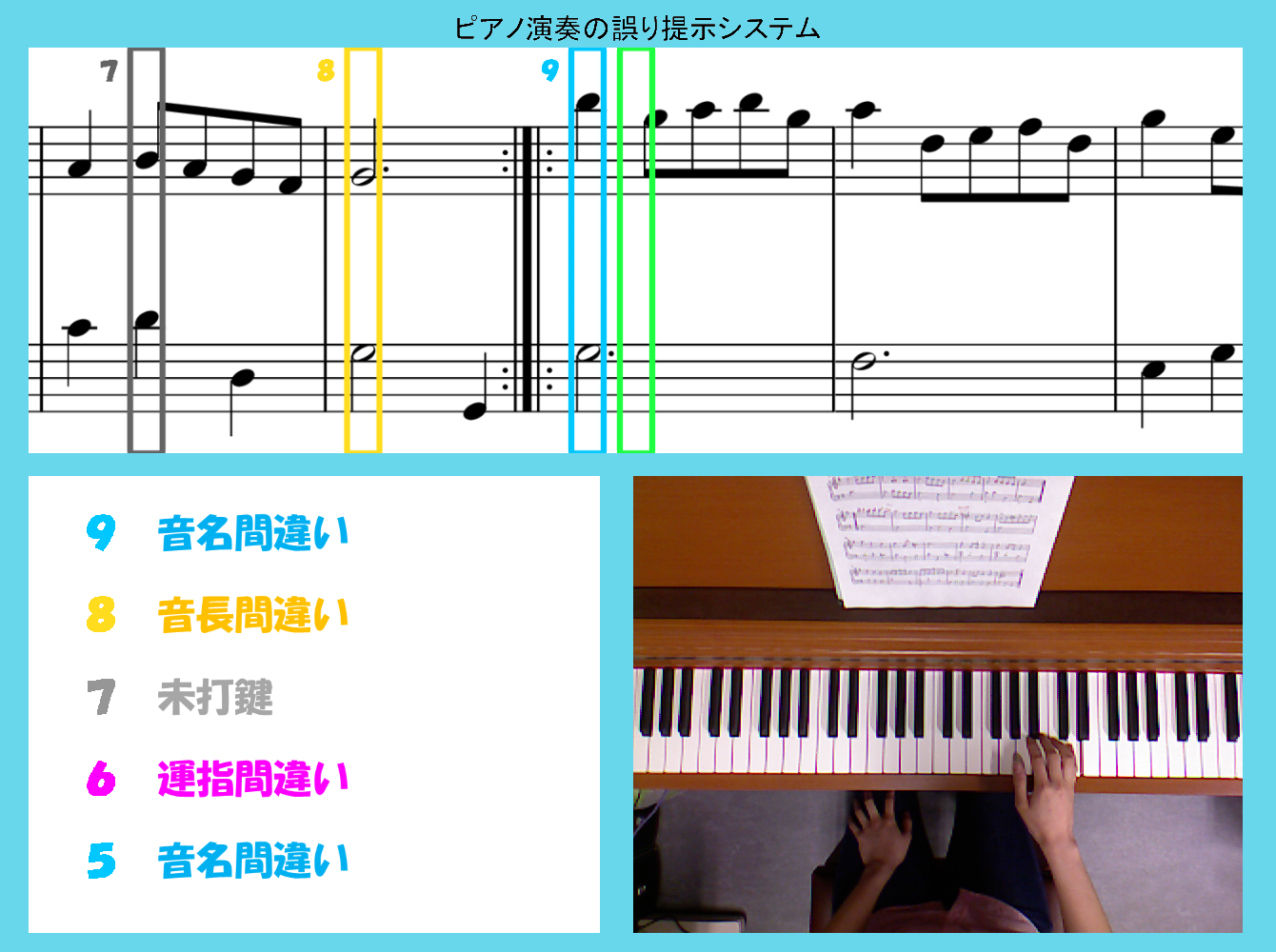

ピアノ演奏の

誤り提示システム

(J.S.Bach, Menuet) |

生産ラインの組み立て作業における手の動作自動記録システム |

|

|

|

|

| 顔キーポイントの移動ベクトルの方向と大きさをコード化(抽象化)することによって,個人依存しにくい表情識別を実現した. |

モノの組み立て作業において手動作と視線情報を自動記録するシステムです. |

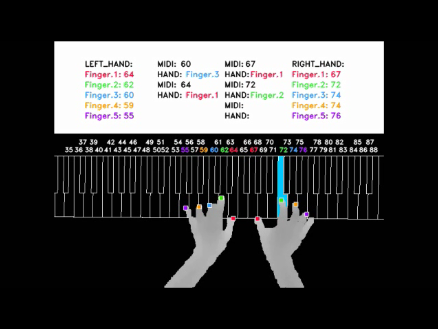

運指認識と音列照合の2つの要素技術を組み合わせた誤り検出に基づく演奏支援システムです. |

3つのシーンごとに動作を記録した結果です.作業時間に着目しながら動作のプロセスを確認できます. |

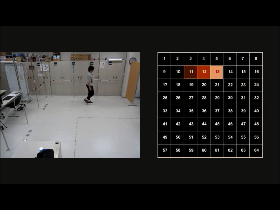

ロボット安全のための

アンビエントセンシング |

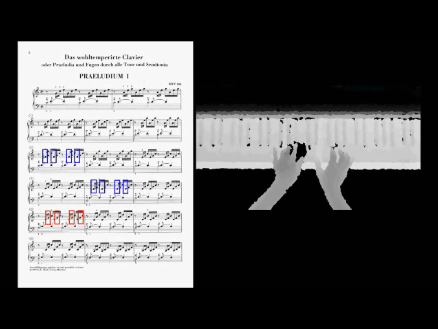

運指とミスタッチを検出

できるピアノ演奏スキル

評価システム

(J.S.Bach, Prelude) |

3-Dハンドモデルを用いた

マーカレス・ピアノ

運指認識

(J.S.Bach, Prelude) |

3-Dハンドモデルを用いた

オンライン画像生成に

基づく仮説検証型

ピアノ運指認識

(メリーさんのひつじ) |

|

|

|

|

| 多数の小型距離センサ群の出力を分析して室内の人物存在位置を推定します.右側は存在位置に対応したセル番号です. |

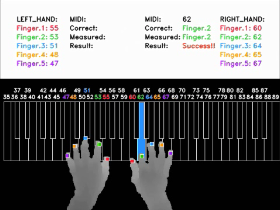

マーカレス運指認識技術と音列照合技術を組み合わせた,スキル評価システムのプロトタイプです. |

汎用3-Dハンドモデルを用いるので演奏者によらず認識可能です.Prelude (J.S.Bach)に適用しました. |

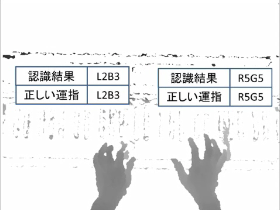

3-Dハンドモデルを用いたピアノ運指認識手法の実験結果です.鍵盤の青色が認識成功を示しています. |

距離画像シーケンスの

分析に基づく

ピアノ演奏における

運指の自動認識

(J.S.Bach, Menuet) |

距離画像シーケンスの

分析に基づく

ピアノ演奏における

運指の自動認識

(かっこう) |

|

|

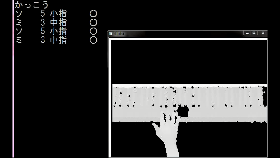

| 学習型ピアノ運指認識手法を,バッハ「メヌエット」に適用しました.青枠は認識成功,赤枠は失敗を示しています. |

ボトムアップ型運指認識手法を「かっこう」に適用してみました.○印は認識成功,×印は失敗を示しています.

実験風景は→こちら |

|

その他の動画

橋本研究室1分間紹介

(物体検出技術) |

|

| 中京大学橋本研究室における物体検出に関する研究成果です.ロボットセンシングに関する技術を3種類ご紹介します. |

|

学部生による実習制作作品

|

橋本研究室では,研究室に配属された学部生に対して,ロボット制御や画像処理,情報処理全般に関する

基礎および応用教育を実施しています.ここでは,学部生(主に2年生)が実習授業で制作した数々の作品

を公開しています. |

2017年度

| 「ハノイの塔」の攻略 |

モーションキャプチャを用いた自動車遠隔操作システム |

ロボットによる商品の袋詰め作業支援システム |

音声認識とYOLOを用いた商品探索システムの開発 |

|

|

|

|

| 色識別を用いた小型ロボット MindStorm の自動制御により,「ハノイの塔」というパズルゲームをクリアしました. |

モーションキャプチャを用いて,人間の運転動作情報を取得し,これに基づいて自動車を遠隔操作するシステムを開発しました. |

形や色情報から商品を認識し,ロボットアームJACOを自動制御することにより,商品の袋詰め作業をおこなうシステムを開発しました. |

音声認識システムにより,欲しい商品の特徴を音声で認識し,YOLOにより,特徴に合った商品を探索するシステムを開発しました. |

| ROSを用いたロボット制御による積み木の自動組み立てシステム |

SRGAN を用いた動画像の高解像度化 |

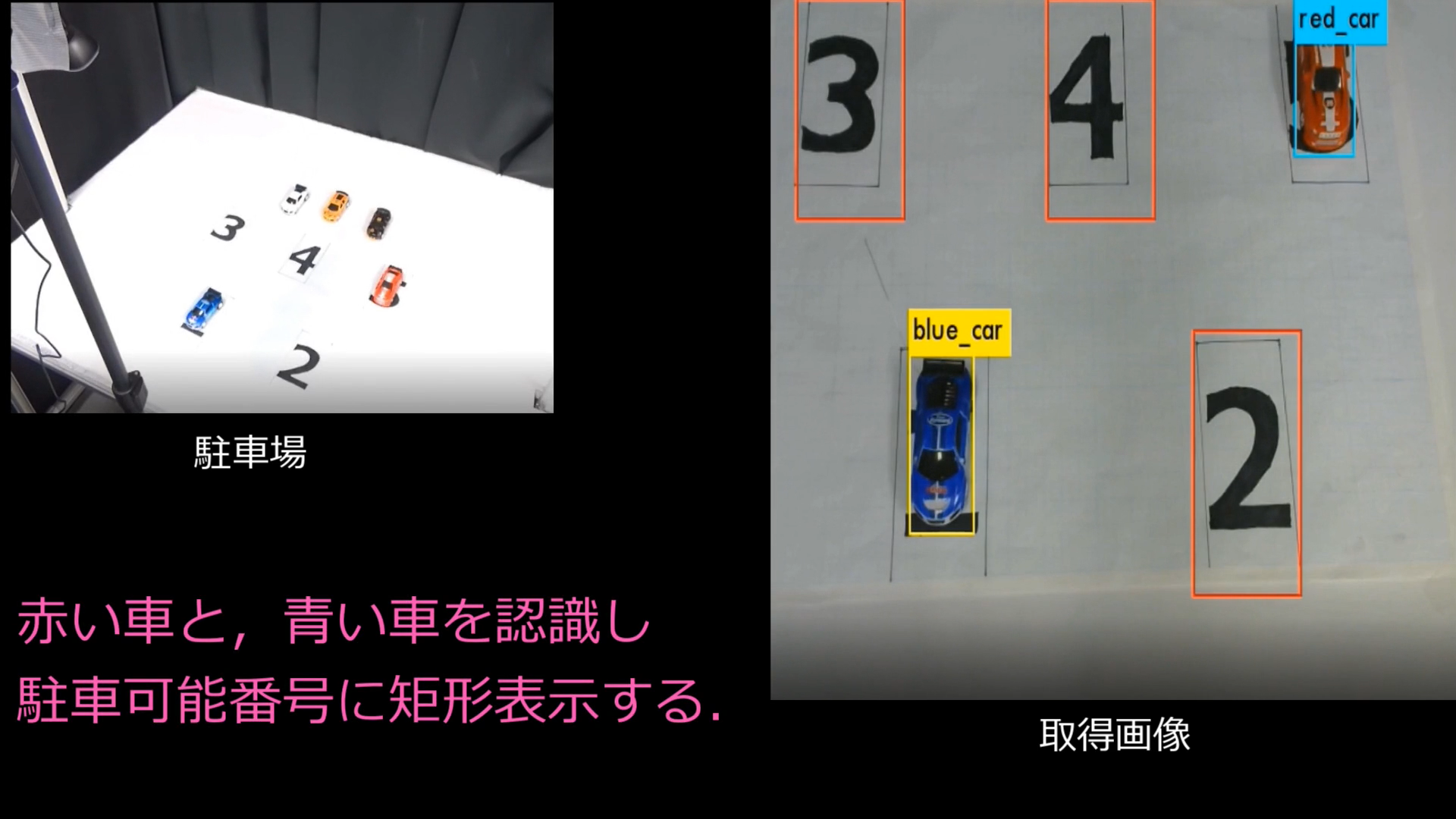

駐車場の空きスペース通知システム |

DCGAN による画像生成を用いた真贋判定ゲームの開発 |

|

|

|

|

| ROSを用いてロボットアームを制御し,ランダムに置かれた4つの積み木を自動で組み立てるシステムを開発しました. |

DeepLearning (SRGAN) を用いて動画像の高解像度化をおこない,元の低解像度の動画像と比較することによって効果を確認しました. |

Deep Learning を用いて,駐車場の駐車可能位置と駐車した車の種類と位置を検出し,通知するシステムを開発しました. |

DCGAN により生成された画像がどれほど自然であるかを確認するために真贋判定ゲームを開発しました. |

|

2016年度

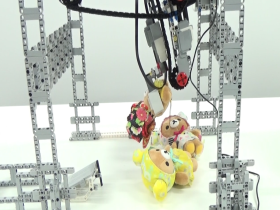

| 自動ピッキングクレーンゲーム |

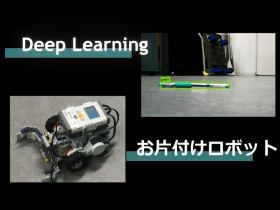

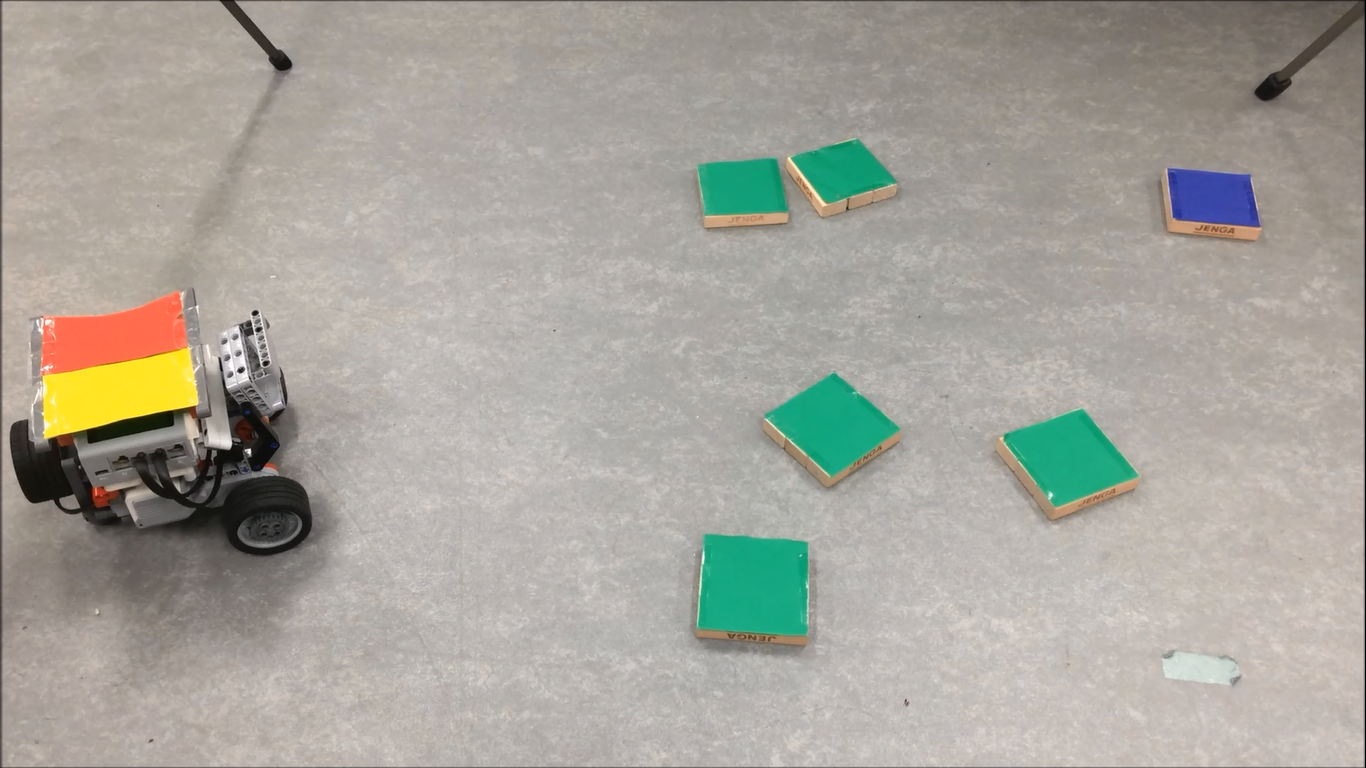

YOLOによる物体認識を

用いた全自動お片付け

ロボットの開発 |

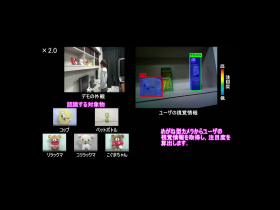

Deep Learningを用いた

物体認識による

注目物体通知システムの

開発 |

対話知能を搭載した

ロボットモデルの

音声操作デモ |

|

|

|

|

| 画像処理によって認識した対象物を自動でピッキングするクレーンゲームを制作しました. |

車載カメラの画像に対してYOLOを用いることで対象物を認識し,NXTが全自動でお片づけをおこなうロボットを開発いたしました. |

Deep Learningを用いて,めがね型カメラから取得した画像中に存在する対象物を検出し,注目度が最も高いものを通知するシステムを開発しました. |

音声で対象物を指定し、シミュレータ内のロボットアームが指定された対象物をピッキングするシステムを制作しました. |

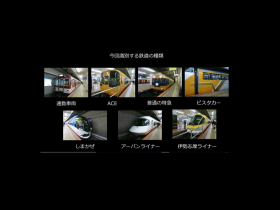

DeepLearningを用いた

鉄道車両の識別 |

YOLOによるリアル物体認識と

連携したROS環境下での

ロボットシミュレータ |

人の表情をまねする

ロボットの開発 |

LeapMotionを用いた

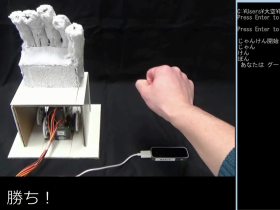

じゃんけんロボットの開発 |

|

|

|

|

| DeepLearningを用いて近鉄名古屋駅に発着する鉄道全7種類を自動で識別するシステムを制作しました. |

YOLOにより認識した対象物を,ROS環境下のロボットシミュレータで把持するデモを制作いたしました. |

人の6表情(驚き,喜び,悲しみ,怒り,嫌悪,恐れ)をまねするロボットを制作しました. |

Leap Motionを用いて人の手の形を認識し,じゃんけんで必ず勝つロボットを制作しました. |

|

2015年度

人間の表情を真似する

顔ロボットの開発 |

自動お片付けロボット |

6DoFロボットアームによる

対象物の自動ピッキング |

ターンテーブル制御と

Kinectを用いた

3D対象物の

全周囲スキャナの開発 |

|

|

|

|

| 人間の「喜び」「悲しみ」「驚き」「怒り」の4種の表情を画像認識し,それらを真似する顔ロボットを制作いたしました. |

障害物を回避しながら,ボールを色によって分別する「自動お片付けロボット」を制作しました. |

画像処理により認識した対象物をピッキングする物流用途を想定したロボットシステムを制作しました. |

自動制御されたターンテーブル上の物体に対してKinectで取得した多視点の3Dデータをもとに全周囲モデルを生成するシステムを開発しました. |

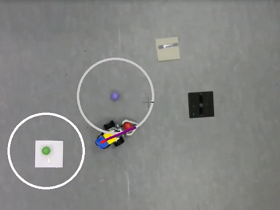

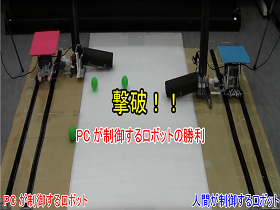

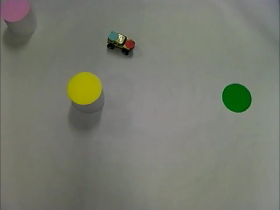

小型走行ロボットを用いた

人間との対戦デモ |

小型ロボット

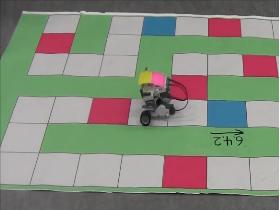

LEGO-Mindstormを用いた

全自動すごろくシステム |

ロボットの

旗揚げ動作を利用した

遠隔メッセージ通信 |

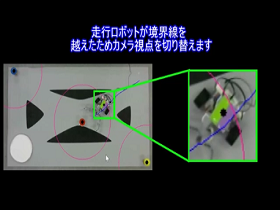

簡便な

ロボット操縦システムと

そのボール運搬への応用 |

|

|

|

|

| PCが制御する砲台型ロボットと,人間が制御する砲台型ロボットが弾を撃ち合って対戦するデモシステムを実現しました. |

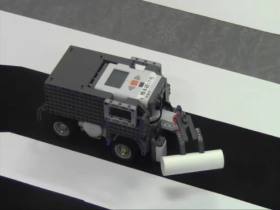

サイコロの目を自動的に画像認識し,出た目のマス分だけロボットが進むすごろくゲームを制作しました. |

ユーザが指定した文字列をコード化してロボットの旗揚げ動作で表現し,それを画像処理して文字列を復元するシステムを開発しました. |

天井とロボットに取り付けられたWebカメラの視点を適応的に切り替えることによって 効率よく対象物(ボール)を運搬するロボットを制作しました. |

|

2014年度

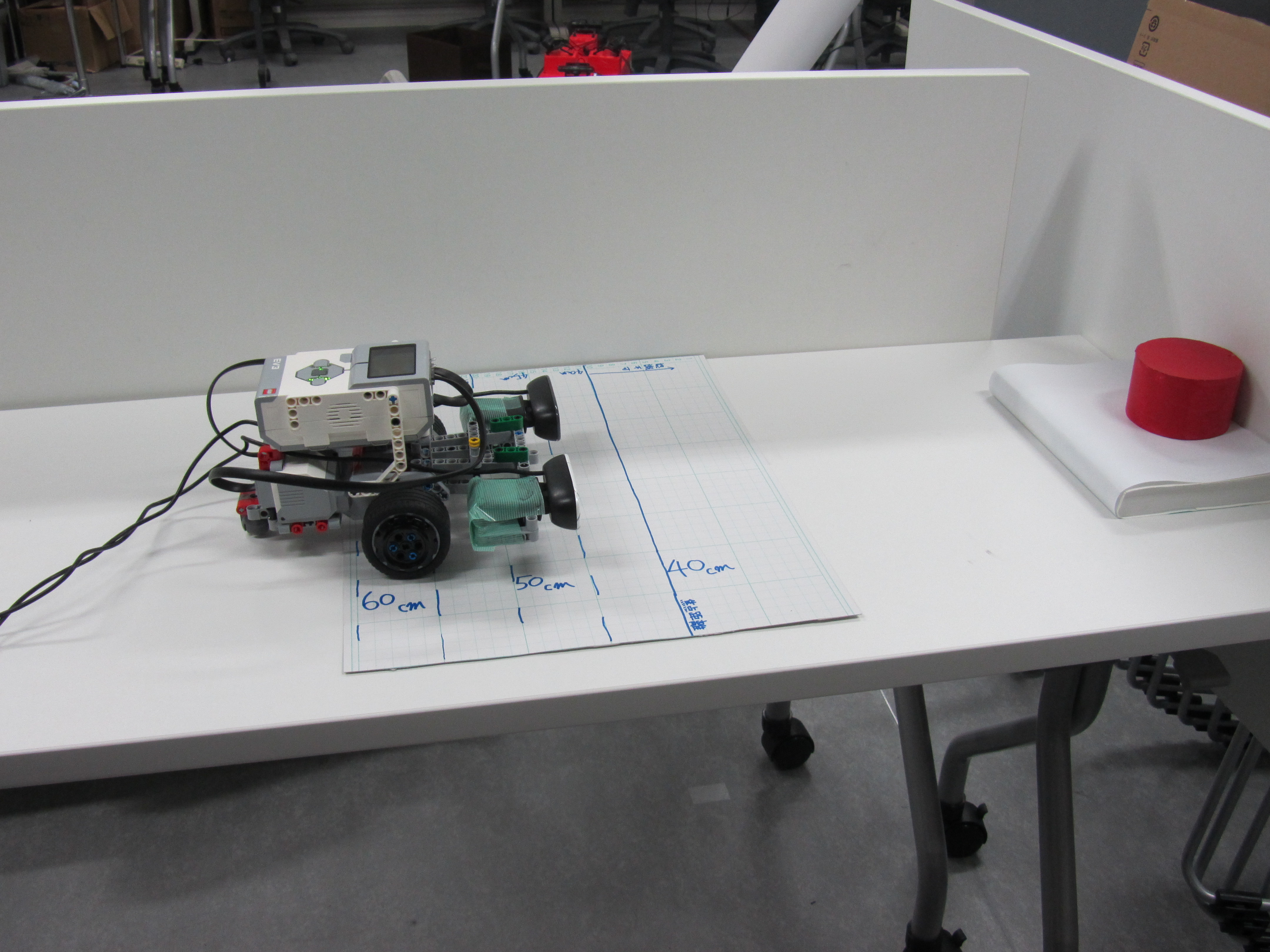

新型Mindstorm(EV3)を

用いた自動走行 |

簡易ロボットアーム

MR-999 の自動制御化 |

新型Mindstorm(EV3)を

用いた自動走行ロボット |

Kinectを用いた

3D独自キャラクタ制作 |

|

|

|

|

| EV3による2つのコースを自動走行するロボットと,複数の障害物がある環境上の自動制御を実現しました. |

手動で制御するロボットアームをカメラで取得された画像をもとにPCで自動制御できるように改造しました. |

EV3による走行ロボットにカメラを接続し,カメラから得られた情報をもとに自動走行するロボットを作成しました. |

Kinectを用いて顔データをセンシングし,PCLの関数を用いて点群データを処理し,3Dプリンタによって独自キャラクタを出力しました. |

サーボモータを用いた

パンチルトカメラの

自動制御 |

ヒューマンビジョンコンポの

表情認識機能による

演奏アプリの開発 |

複数カメラを用いた

ラジコンカーのアラウンド

ビューモニターの制作 |

ラジコンカーの自動制御

によるプラトーン走行 |

|

|

|

|

| 人の顔を検出し,常に画面の中心に捉え続け,写真を撮影するカメラを制作しました. |

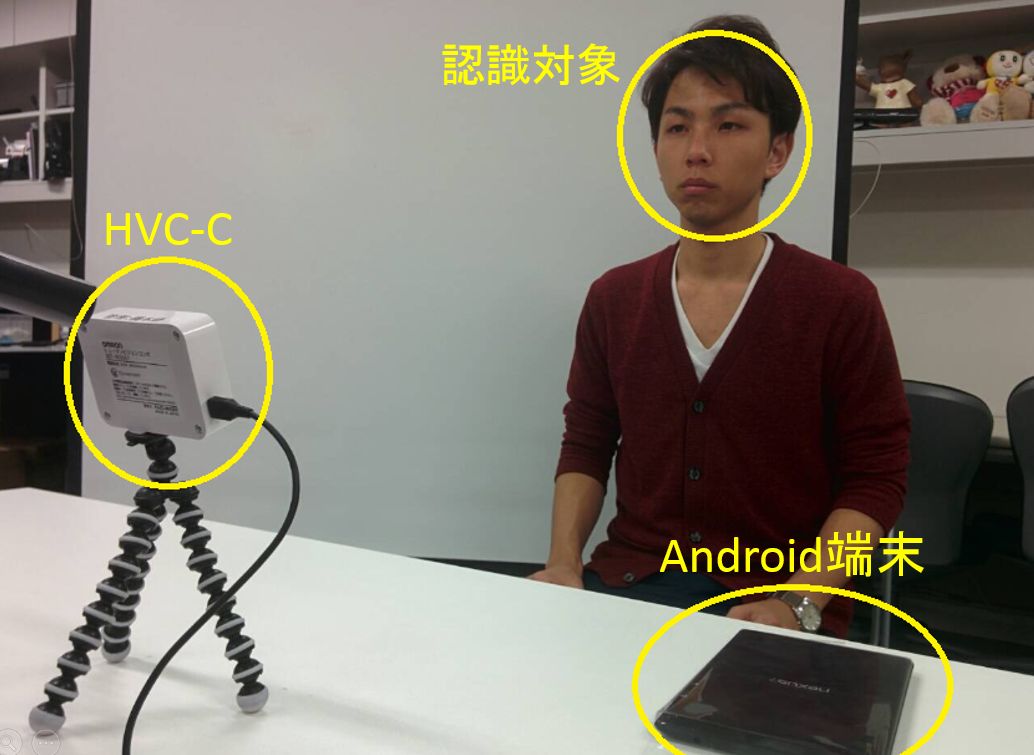

HVC-Cを用いて表情を認識することにより,表情に対応した音楽を流す携帯端末のアプリを作成しました. |

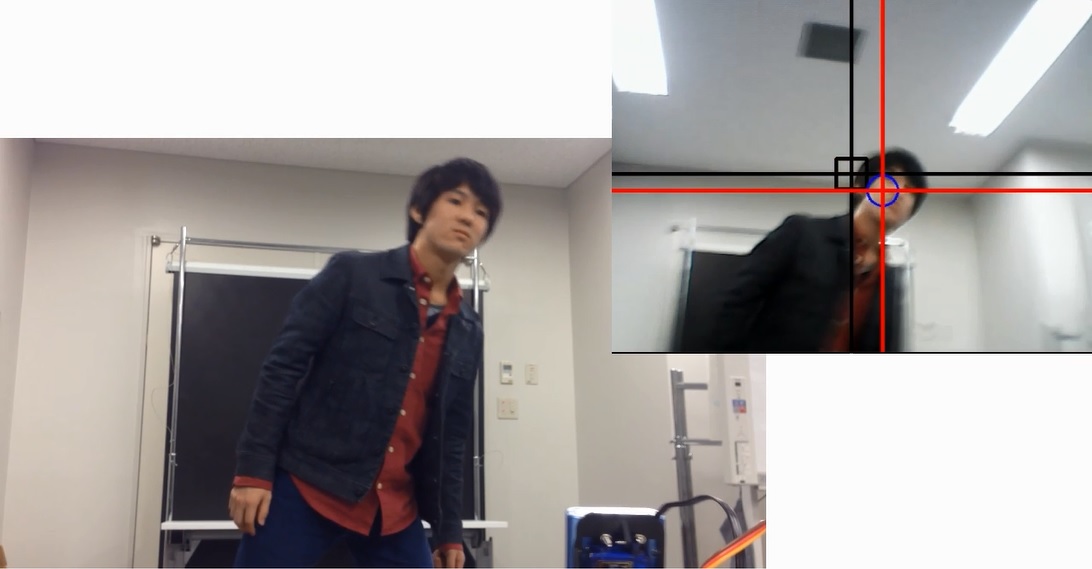

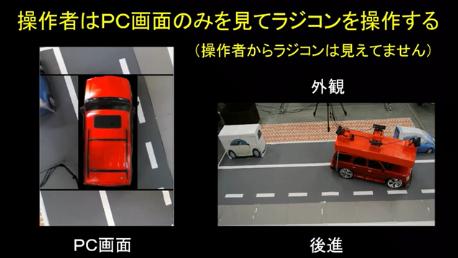

アラウンドビューモニターを作成し,このモニターによってラジコンカーを操作し,縦列駐車します. |

ラジコンカーに設置したマーカーを検出し,自動でラジコンカーを制御し,プラトーン走行します. |

Leap Motionを用いた

シューティングゲームの

開発 |

Kinectのジェスチャー

認識を用いたものまね

ロボットによるボクシング |

|

|

| Leap Motionを利用して指先座標を取得し,その座標を用いたシューティングゲームを開発しました. |

Kinectで人のジェスチャーを認識し,ロボットが人の動きをまねし,ボクシングします. |

|

2013年度

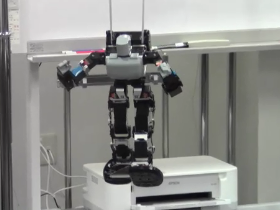

Kinectセンサを用いた

ものまね

ヒューマノイドロボット |

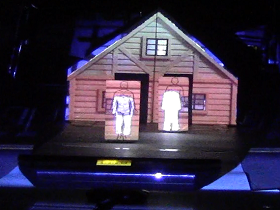

平面動物体に対する

プロジェクションマッピング |

Kinectを用いた

体感型ブロック崩しゲーム |

Webカメラを用いた

メガローバーの制御による

自動追尾走行 |

|

|

|

|

人間の手足のジェスチャーをセンサを使って認識し,人間型ロボットに同じ動作をさせてみました.

|

Kinectを用いて平面物体(建築物と歩行者)を認識し,適応的に合成映像を投影できました. |

人間のジェスチャーを認識して,ブロック崩しゲームを体感的に操作するプログラムを開発しました. |

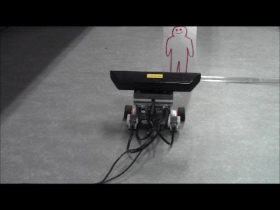

台車型ロボットにPCと小型カメラを搭載し,色認識に基づく歩行者追尾を実現しました. |

Kinectを用いた

メガローバー制御による

障害物回避走行 |

プロジェクタとターンテーブル

を用いた光切断による

全周囲モデラー |

Kinectを用いた

人間の動作認識による

MindStorm制御 |

Androidを用いた顔認証 |

|

|

|

|

| 台車型ロボットにPCと距離センサを搭載し,いま流行の自動走行を実現しました. |

光切断の原理を用いて,ターンテーブル上の3次元物体を計測し,全周囲モデルを生成しました. |

人間の動きやジェスチャーを認識して,小型ラジコン自動車を自由自在に制御するゲームを開発しました. |

カメラ映像からの顔検出および登録した特定の顔の認識プログラムを,Android端末に実装しました. |

Mindstormsを用いた

安全自動車(ASV)の開発 |

RaspberryPiによる

移動物体検出 |

Gainer miniを用いた外部電子回路制御実験

【押しボタン式加算器】 |

Gainer miniを用いた外部電子回路制御実験

【ワンタッチ画像処理】 |

|

|

|

|

| LEGO MinadstormsにKinectセンサを搭載し,障害物や歩行者を認識して安全な走行を実現しました. |

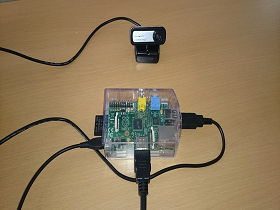

超小型PCである"ラズベリーパイ"にカメラを接続し,移動ブツの検出と記録を実現しました. |

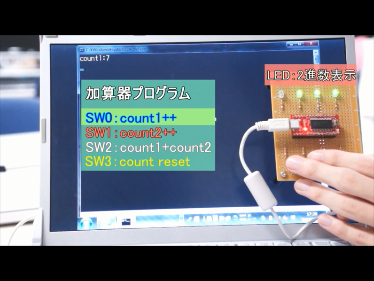

Gainer miniで回路を制御し,加算器の動作をするプログラムを製作しました. |

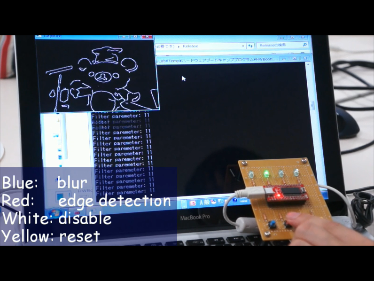

Gainer miniで回路を制御し,スイッチのON/OFFで画像処理するプログラムを作成しました. |

|

2012年度

LEGO Mindstormsによる

ボール運び |

LEGO Mindstormsによる

2次元マーク認識 |

道路標識認識による

LEGO Mindstormsの

自律走行 |

MELFAハンドアイによる

構造物自動組み立て |

|

|

|

|

LEGO Mindstorms上のカ

メラ映像をBluetooth経由でPCに転送し,ボールの自動認識と運搬を実現しま

した.

|

LEGO Mindstormsにカメラを搭載し,矢印(→)の方向を認識するVisualFeedback

走行車を試作しました. |

LEGO Mindstormsを用いて道路標識を認識し,標識に従って自律走行します. |

ロボットアームMELFAに搭載したカメラで設計写真を認識し,積み木をピッキングして構造物を組み立てます. |

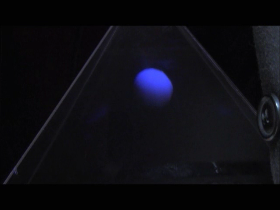

ペッパーズゴースト錯視を

用いた3次元Viewer |

PCによる

ビュートローバーの

モータ制御 |

|

|

| ペッパーズゴースト錯視の原理を応用して,アクリル板ピラミット内に3次元物体のアニメーションを作成しました. |

PCで生成したモータ制御データをBluetooth経由でVstone Beauto Roverに転送し,走行制御します. |

|

2011年度

LEGO Mindstormによる

アームロボットの

開発と制御 |

LEGO Mindstormによる

顔の自動追尾 |

MELFAハンドアイによる

3種類の

円柱識別&挿入 |

視線検出による

関心度測定 |

|

|

|

|

| LEGO Mindstormsを用いた全自動クリケットロボットを開発しました.逆運動学を解いて,関節角を演算しています. |

LEGO Mindstormsに搭載したカメラ映像をBluetooth経由でPCに転送し,顔の追跡を実現しました. |

ロボットアームMELFAのハンドアイで円柱と円孔を認識し,3点レーザ測距により斜め挿入を実現しました. |

ユーザーの視線を検出し,

連続注視時間による関心度評価グラフを表示します. |

CPTMを用いた

超高速カメラぶれ補正 |

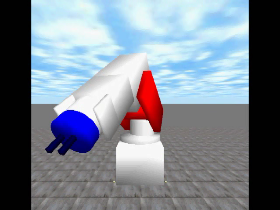

ODEを用いた

リアルなロボットアームの実現とシミュレーション |

|

|

高速テンプレートマッチング

(CPTM)を用いた動画像のぶれ補正を実現しました. |

ODE(Open Dynamic Engine)を用いたロボットアームMELFAの動作シミュレータを作成しました. |

|

2010年度

外部監視カメラを用いた

ラジコン制御 |

Kinectを用いた

Z-Keyによる

事前撮影映像との

リアルタイム

スーパーインポーズ |

Kinectを用いた

Foot Piano |

Kinectを用いた

未来の楽器 |

|

|

|

|

| 障害物に囲まれたラジコンカーを上空から撮影して位置と姿勢を認識し,自動制御で目的地に走行します. |

Kinectで撮影して人体領域を抽出し,リアルタイムでカメラ映像と合成します. |

Kinectを用いて足先の位置を検出し,踏んだ鍵盤の音を鳴らす Foot Piano です. |

Kinectで手のジェスチャー

を認識し,ビープ音源の周波数やビブラートを変化させます. |

Kinectを用いた

ロボットアームMELFAの

ジェスチャー操作 |

BoFを用いた

自動カロリー計算 |

缶飲料図柄の識別 |

BoFを用いた

スイーツの自動分類 |

|

|

|

|

| Kinectで認識した手のジェスチャーをもとに,ロボットアームMELFAを制御するテレオペレーションを試作しました. |

ラーメン・カレー・カツ丼の3種の学食メニューを認識し

,カロリー量を表示します. |

Webカメラの映像から手に持った缶を自動検出し,缶ビールの銘柄を識別します. |

BoF(Bug of Feature)を使って5種類のスイーツを識別するプログラムを制作しました. |

|

2009年度

小型ロボットiSOBOTに

よるボール発見と追跡 |

4ビットマイコンを用いた

外部接続LED表示制御 |

ロボットアームと

LED制御による

画像データベース

自動構築システム |

エンコーダレス

ロボットアームの

ビジュアル

フィードバック制御 |

|

|

|

|

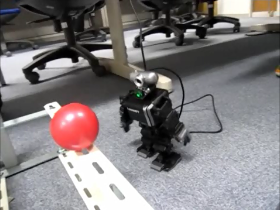

| iSOBOTに搭載したカメラでボールを探索し,追跡するビジュアルフィードバックを実現しました. |

4ビットマイコン(「大人の科学」付録)を改造して,外部接続LEDを表示させました. |

ロボットアームにLEDライトを装着し,約1000パターンの照明条件の画像を自動取得します. |

アーム型の玩具ロボットMR-999を改造して,PCから制御できるようにしてみました. |

SIFTアルゴリズムの

Cygwinでの動画処理 |

TOFセンサによる

ジャンケン認識システム |

2カメラによる

視差動画像の

自動生成と

簡易立体表示 |

倒立振子に関する

理論と実装 |

|

|

|

|

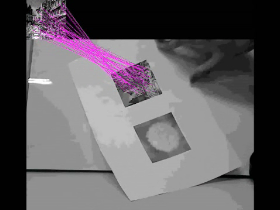

| キーポイント型物体検出の代表的手法であるSIFTアルゴリズムを動画像に適用してみました. |

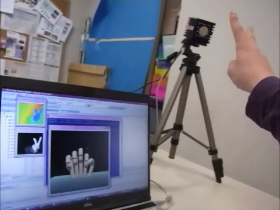

TOFセンサを用いて,人間のじゃんけんの手を認識するシステムを開発しました. |

2台のWEBカメラを使用してアナグリフ式の視差動画像を作成しました. |

ビュートバランサーのモータ出力値を調整して,倒立振子を安定に動かしています.

|

|

▲Topへ

|