Last updated: Apr. 23, 2019.

研究成果,および研究室所属の学部生による実習制作作品に関する動画を Youtube で公開しています.各画像をクリックすると Youtube で動画を再生します.

■研究成果デモ動画

3次元センシング技術 画像センシング技術 ヒューマンセンシング技術 その他の動画

■学部生による実習制作作品(教育成果)

2018年度 2017年度 2016年度 2015年度 2014年度 2013年度 2012年度 2011年度

2010年度 2009年度

新着動画

研究成果デモ動画

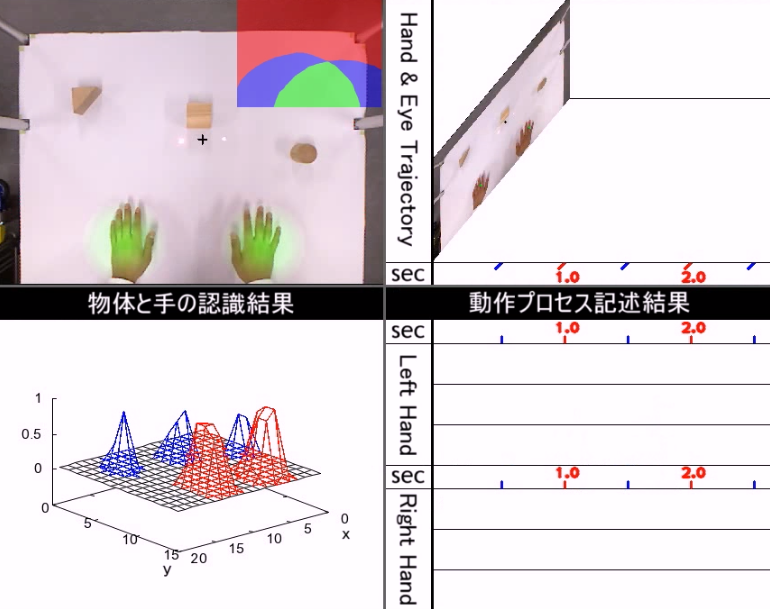

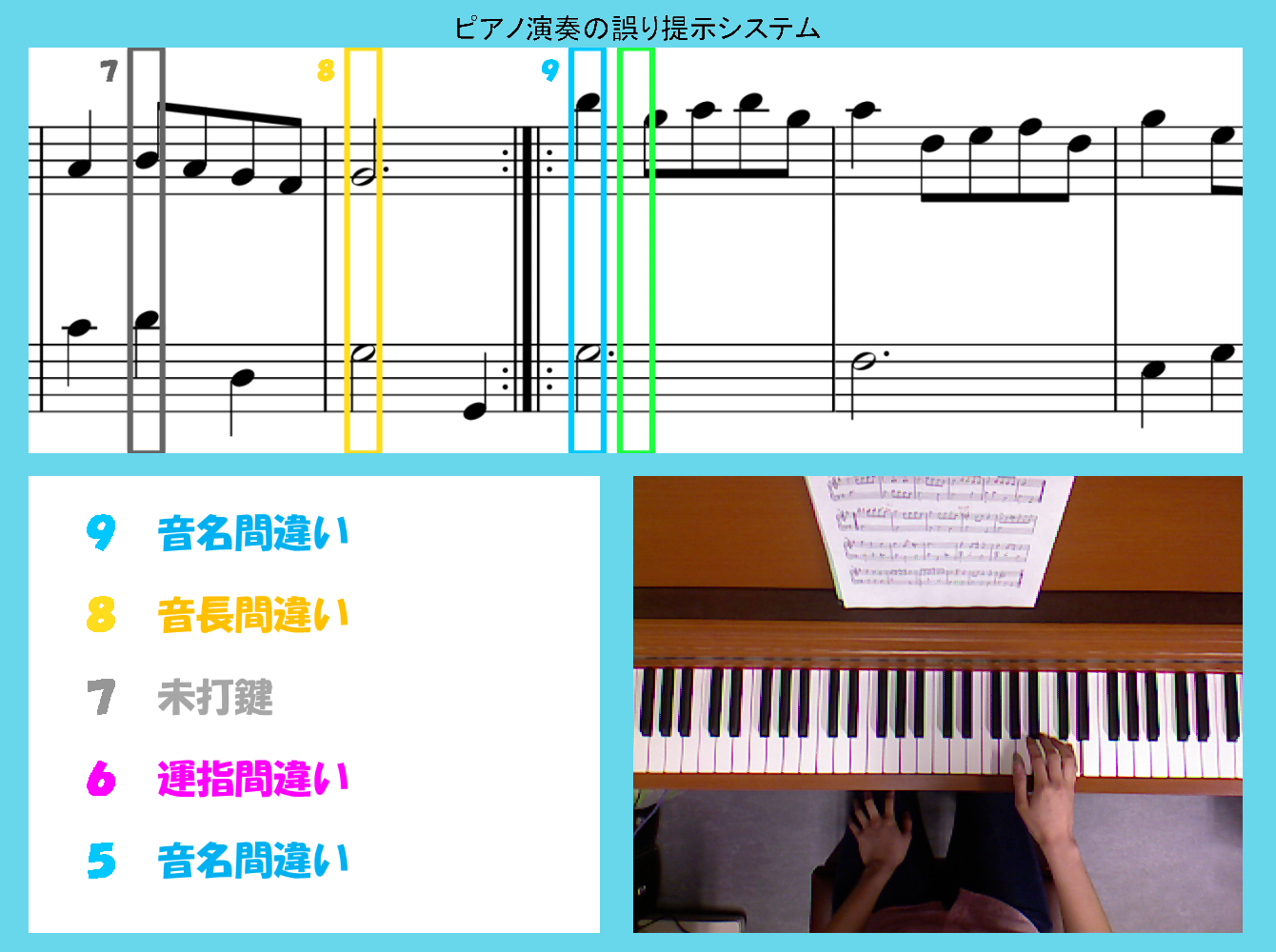

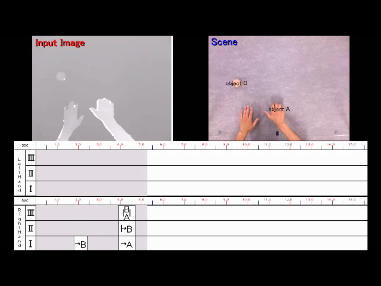

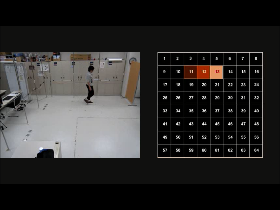

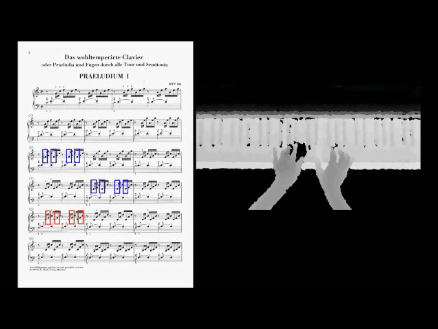

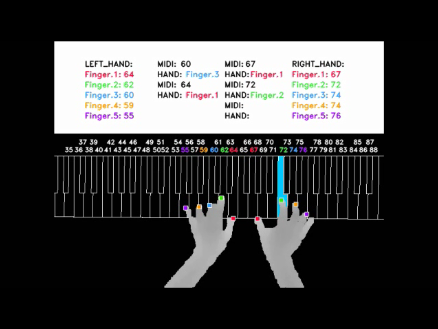

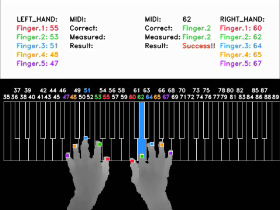

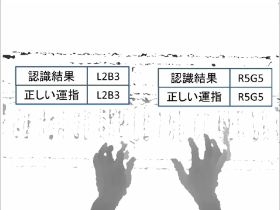

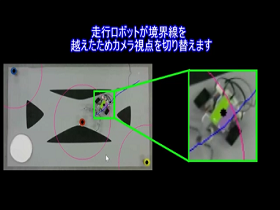

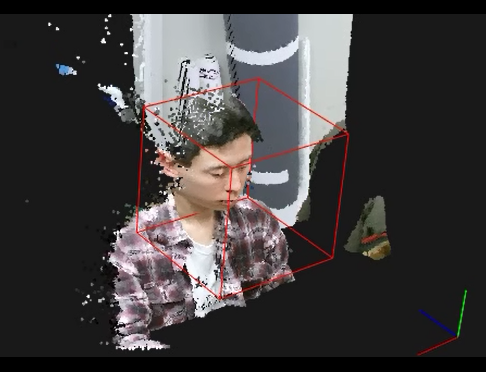

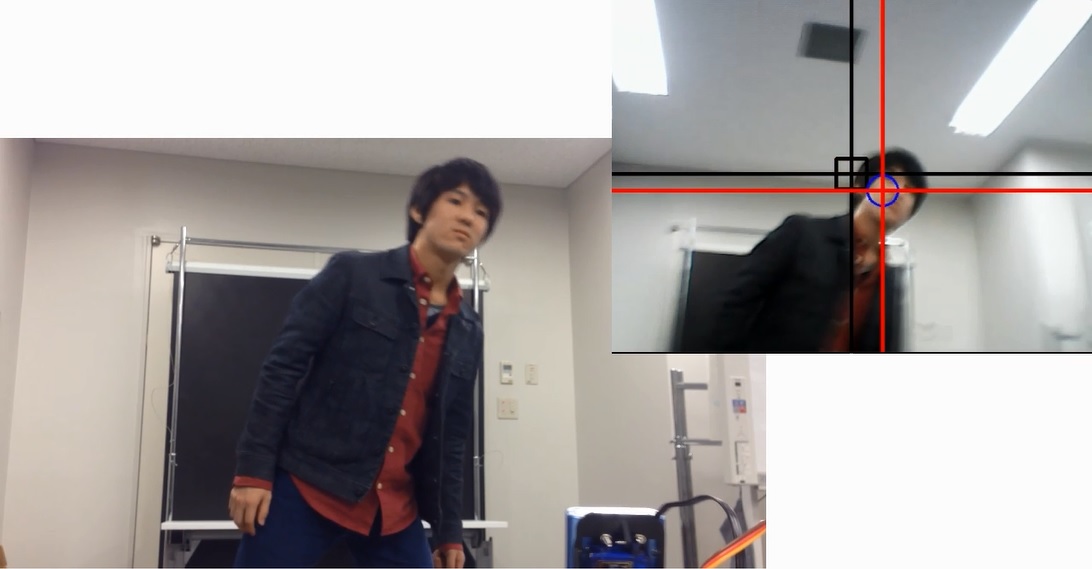

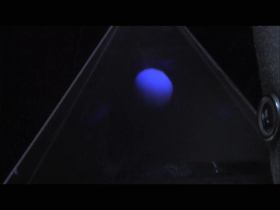

橋本研究室では,3次元センシング,画像センシング,ヒューマンセンシングの3つの研究領域において,先進的かつ実用的な研究を行っています.

ここでは,学会発表等で紹介したデモや実験に関する動画を公開しています.

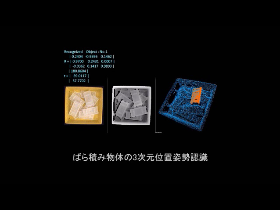

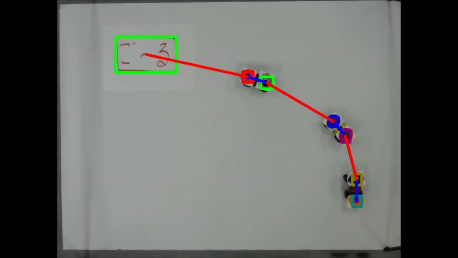

3次元センシング技術

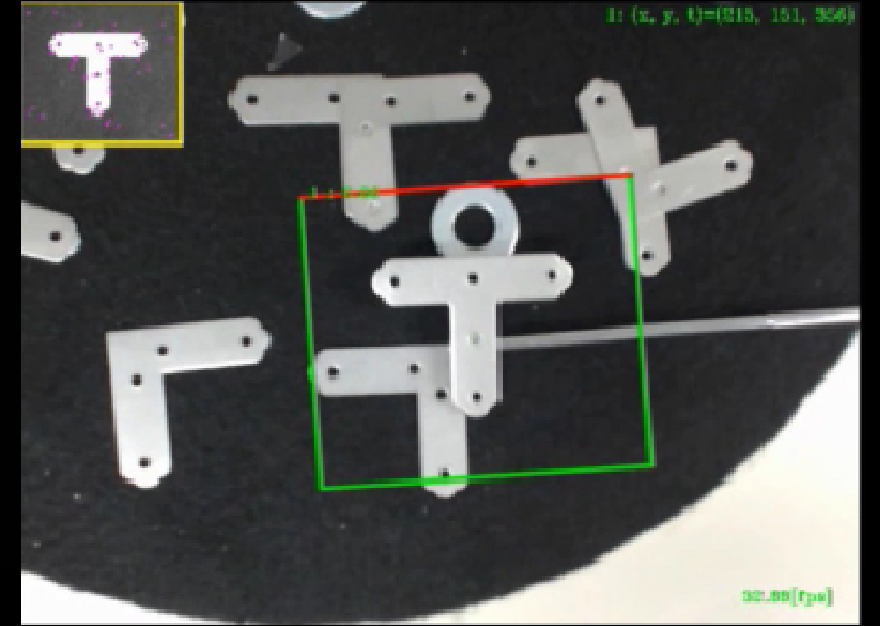

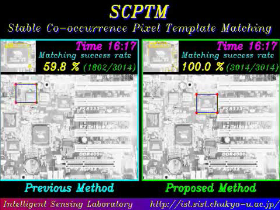

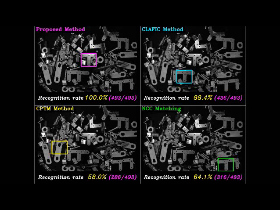

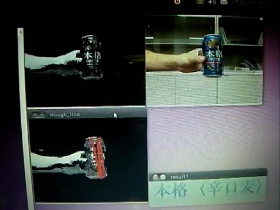

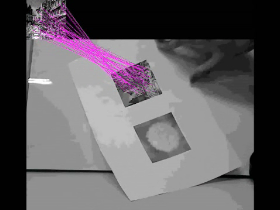

画像センシング技術

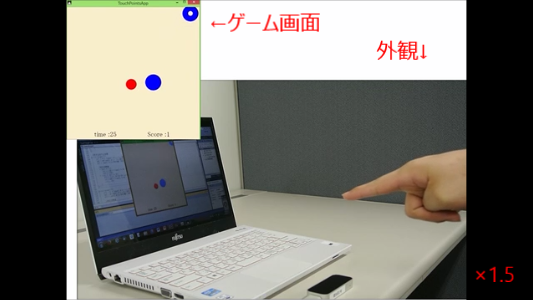

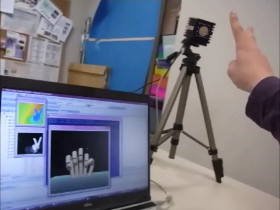

ヒューマンセンシング技術

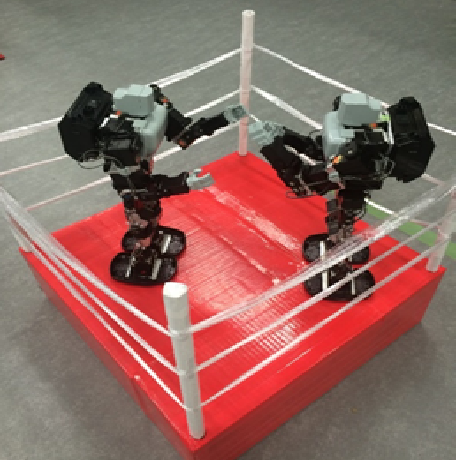

その他の動画

橋本研究室1分間紹介

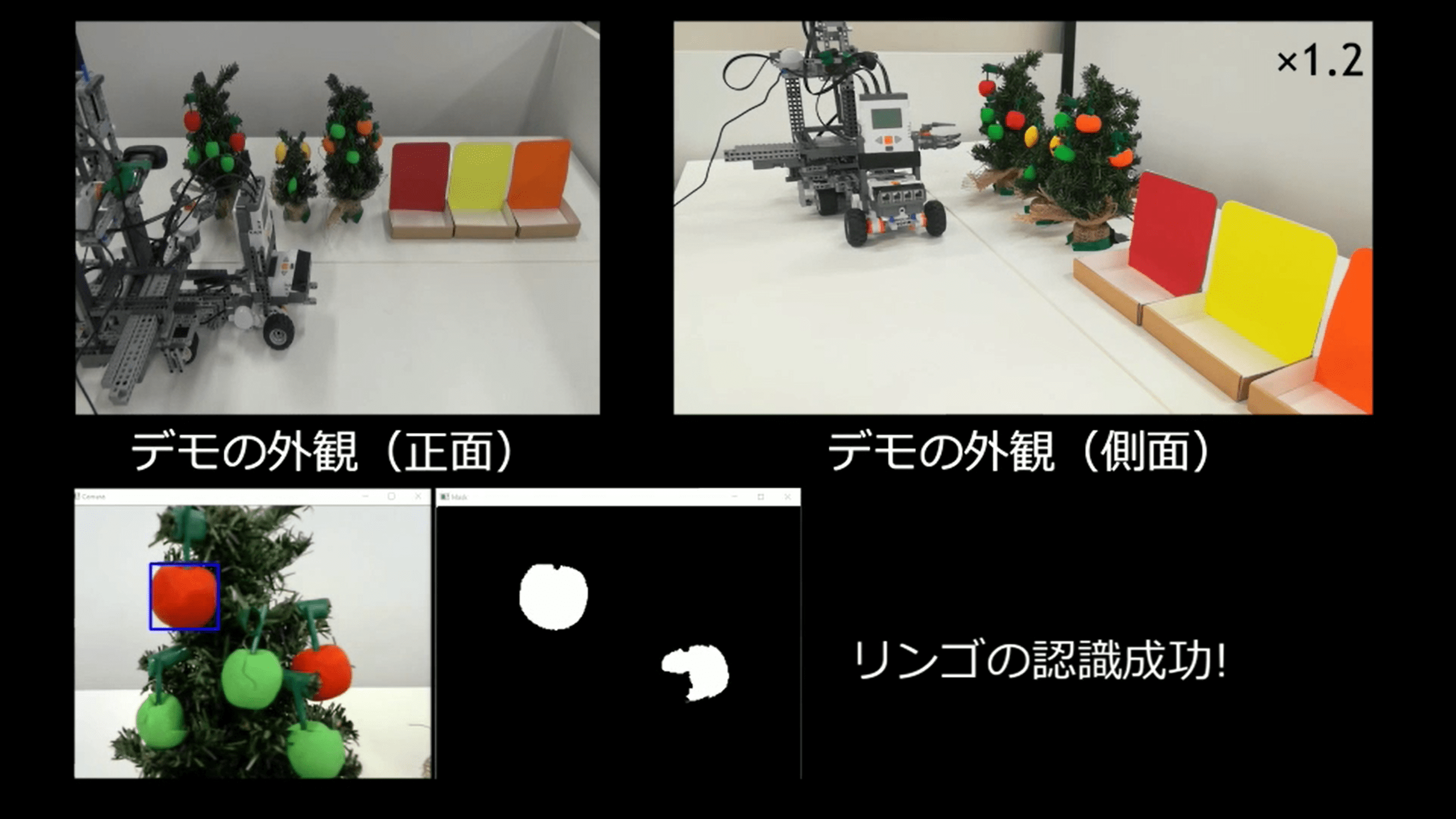

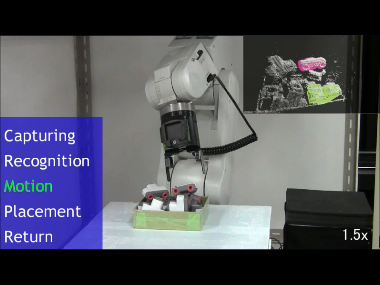

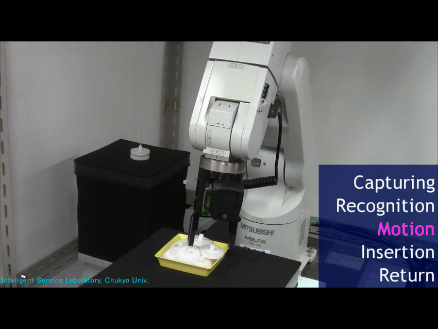

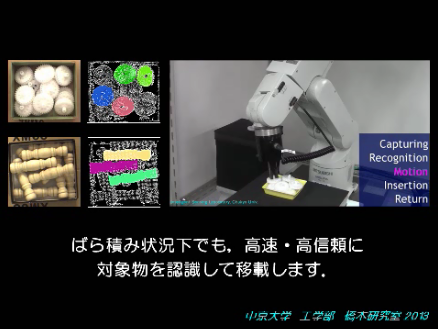

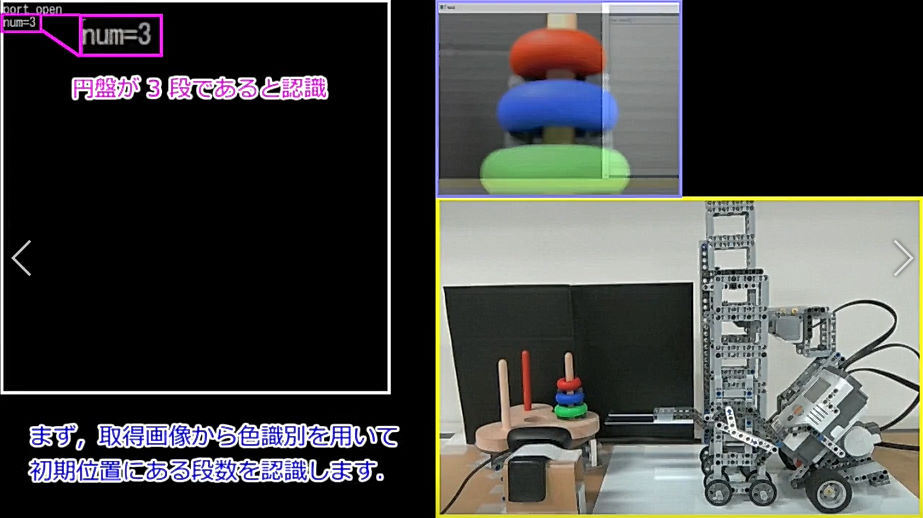

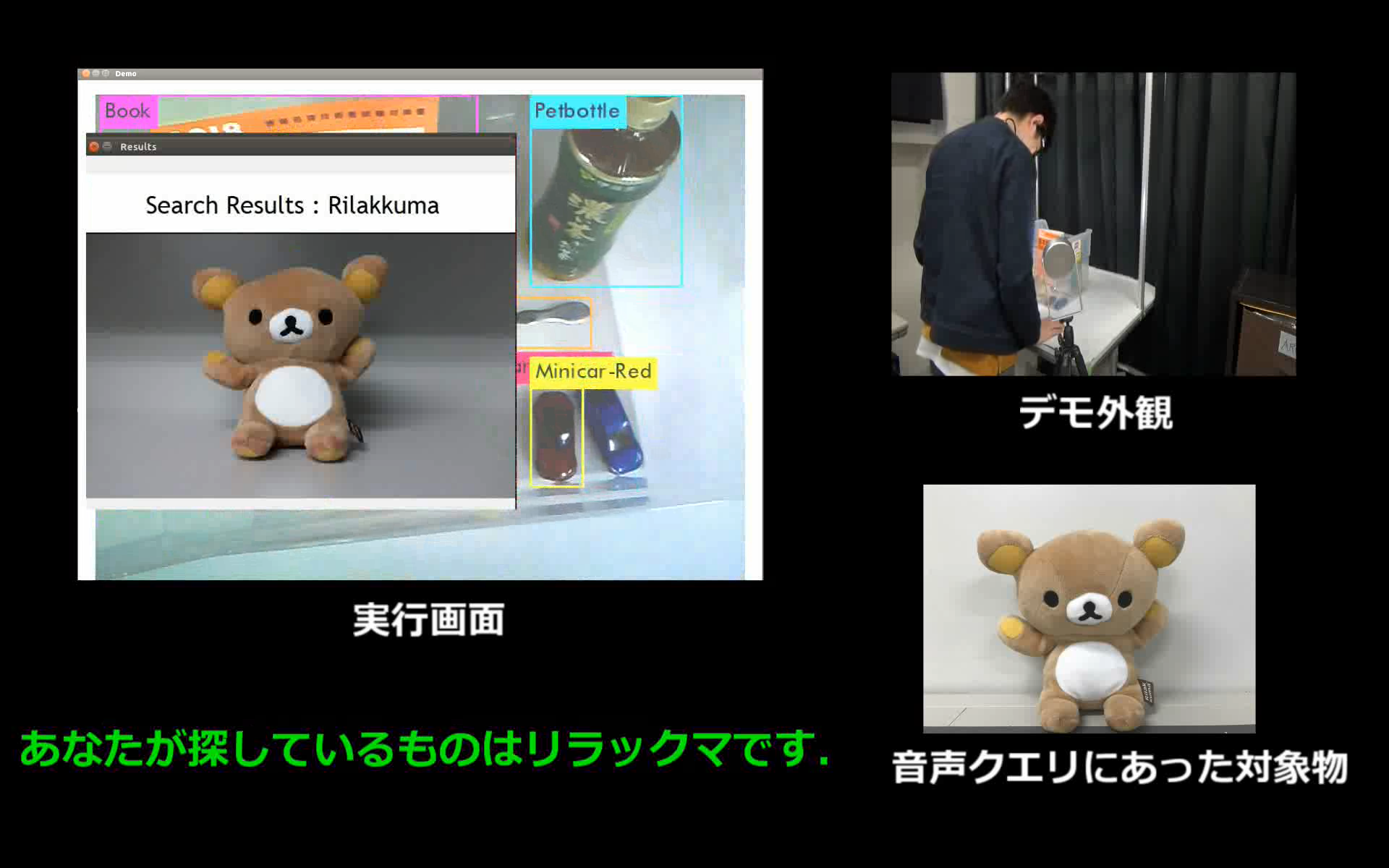

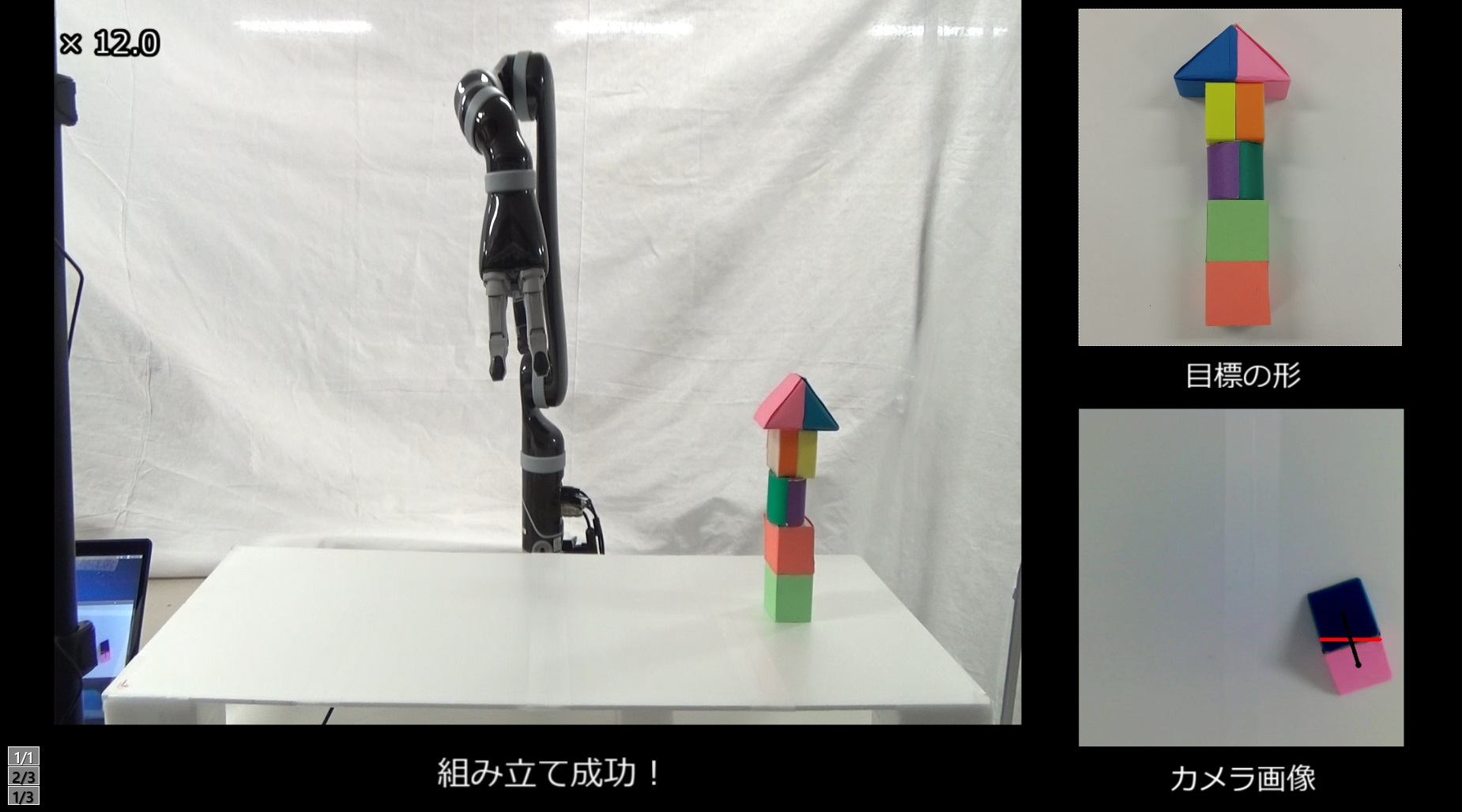

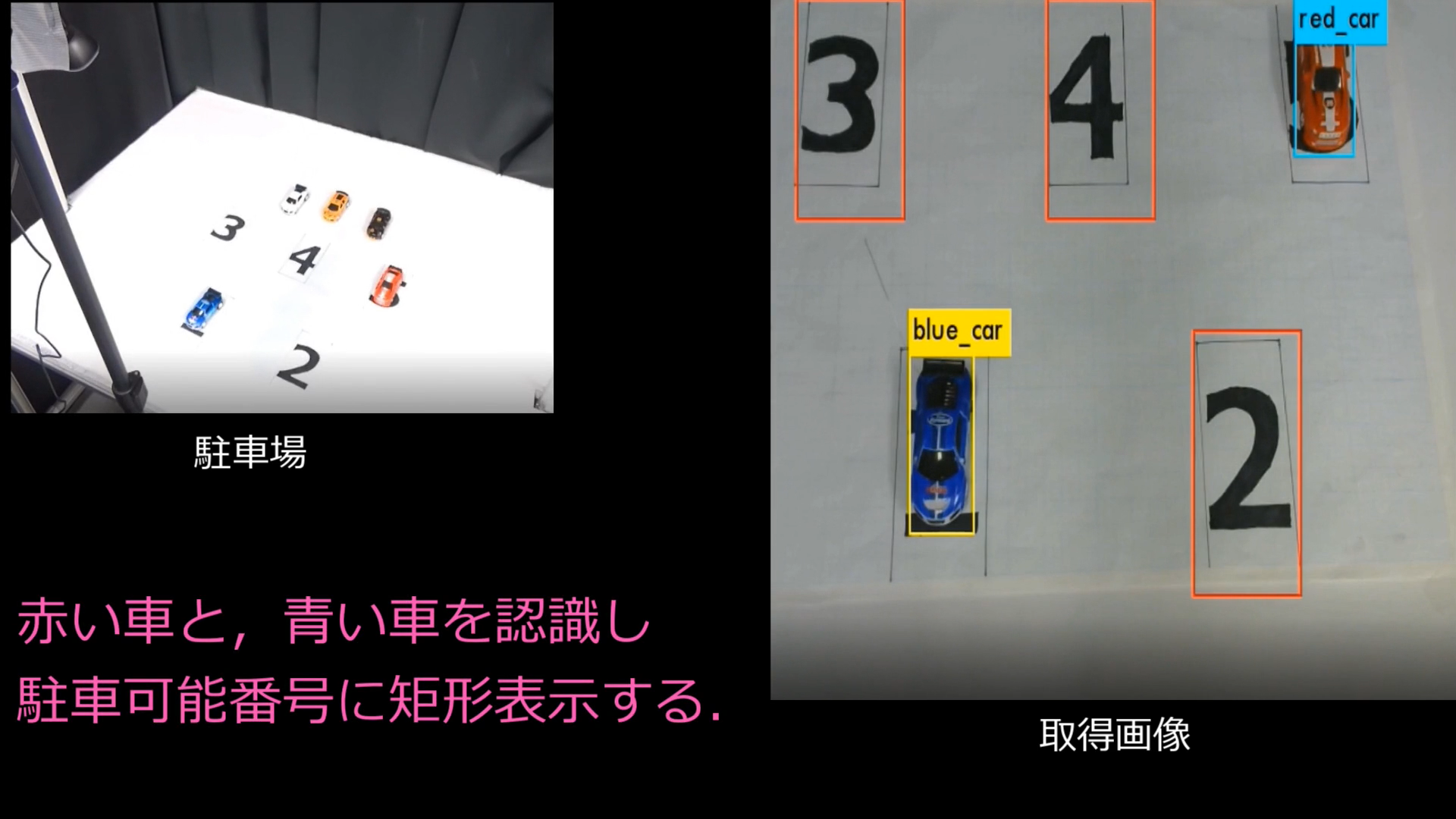

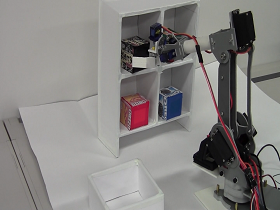

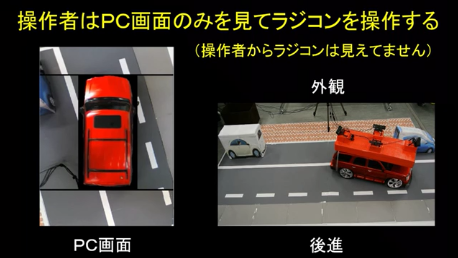

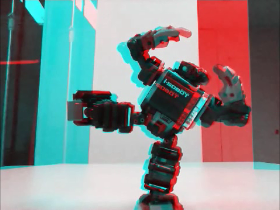

(物体検出技術) |

|

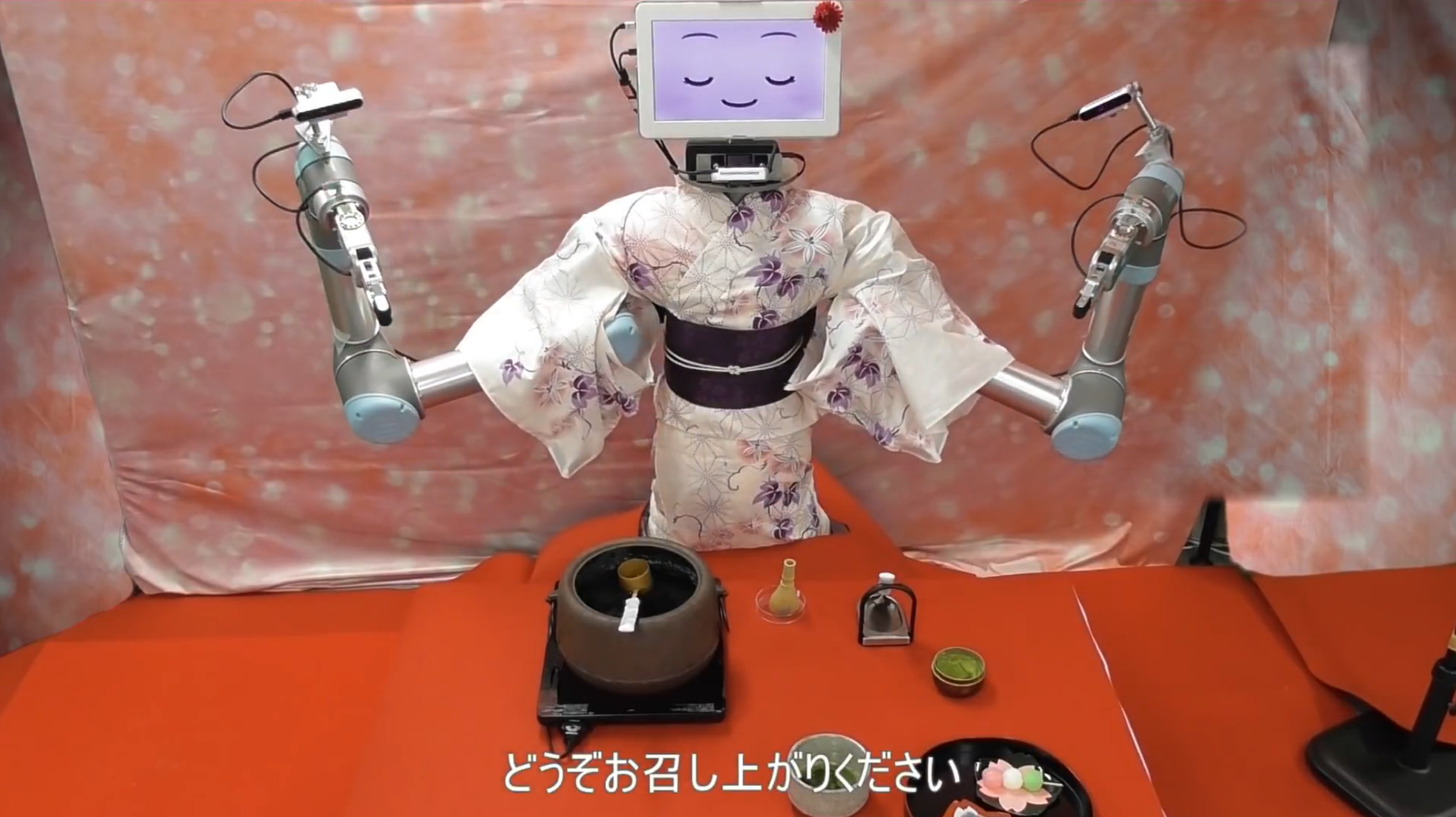

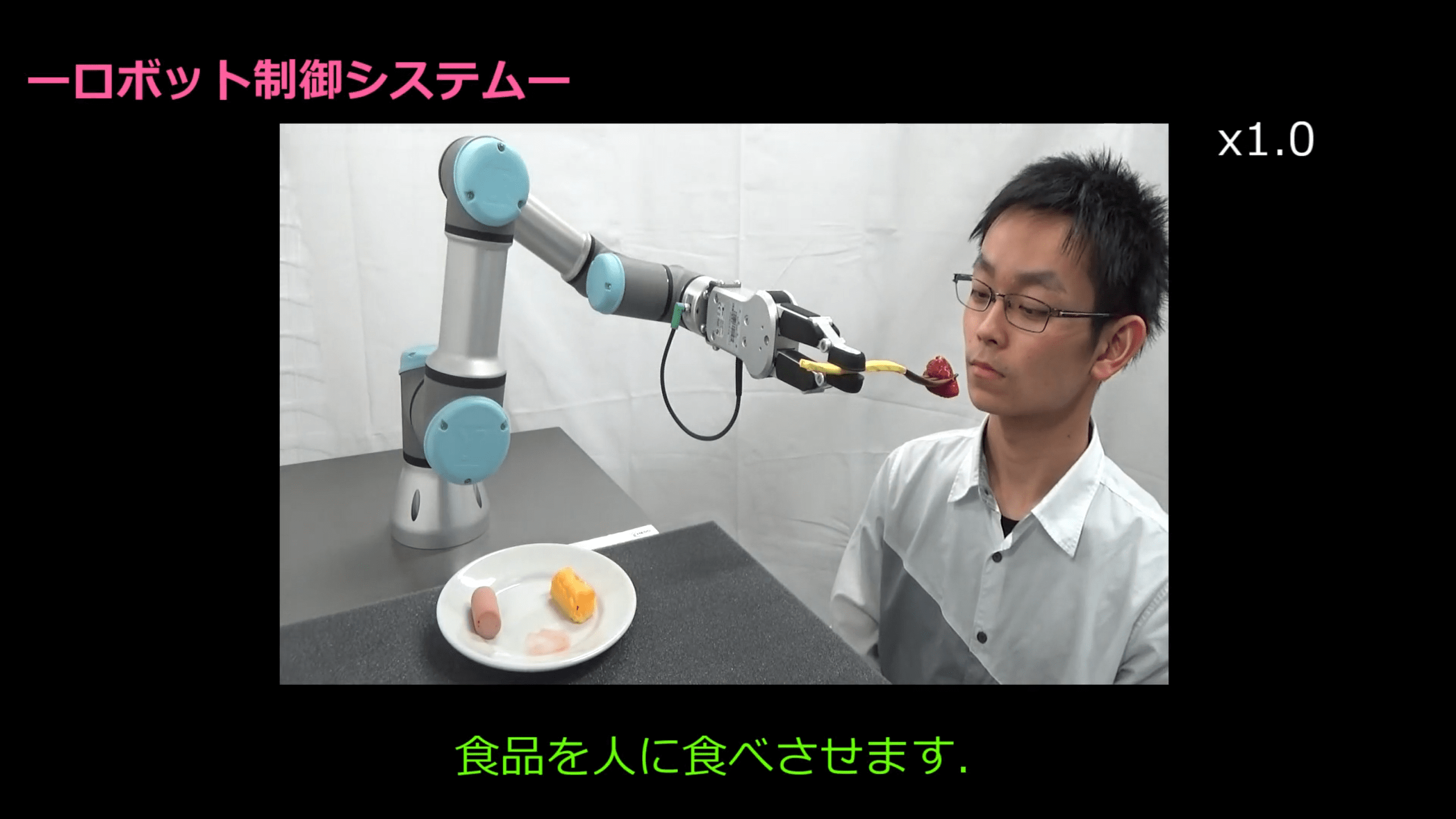

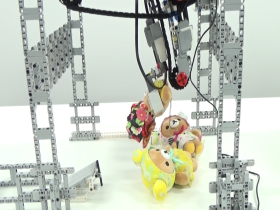

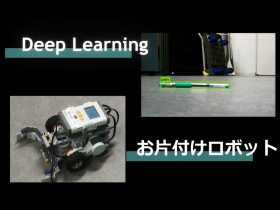

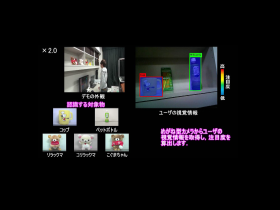

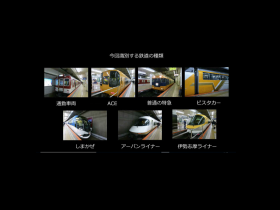

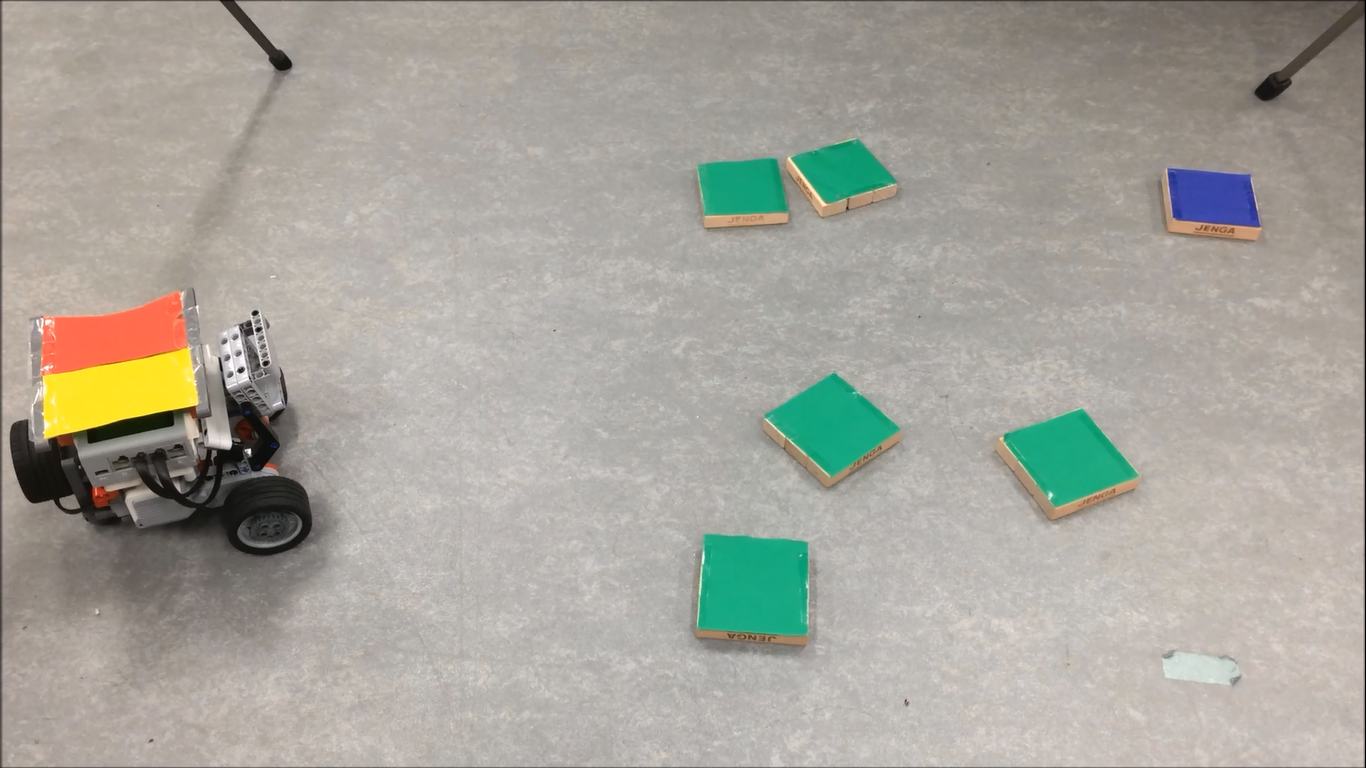

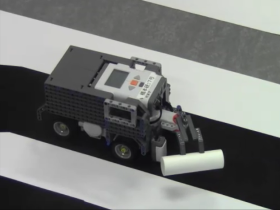

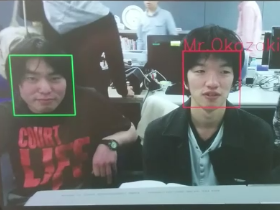

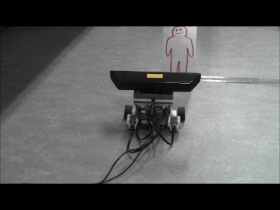

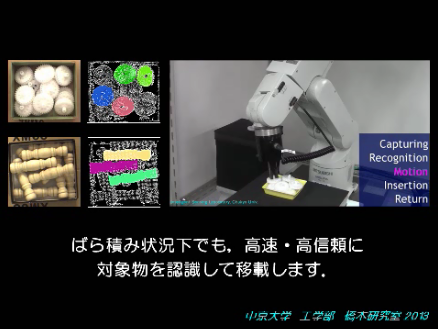

| 中京大学橋本研における物体検出に関する研究成果です.ロボットセンシングに関する技術を3種類ご紹介します. |

|

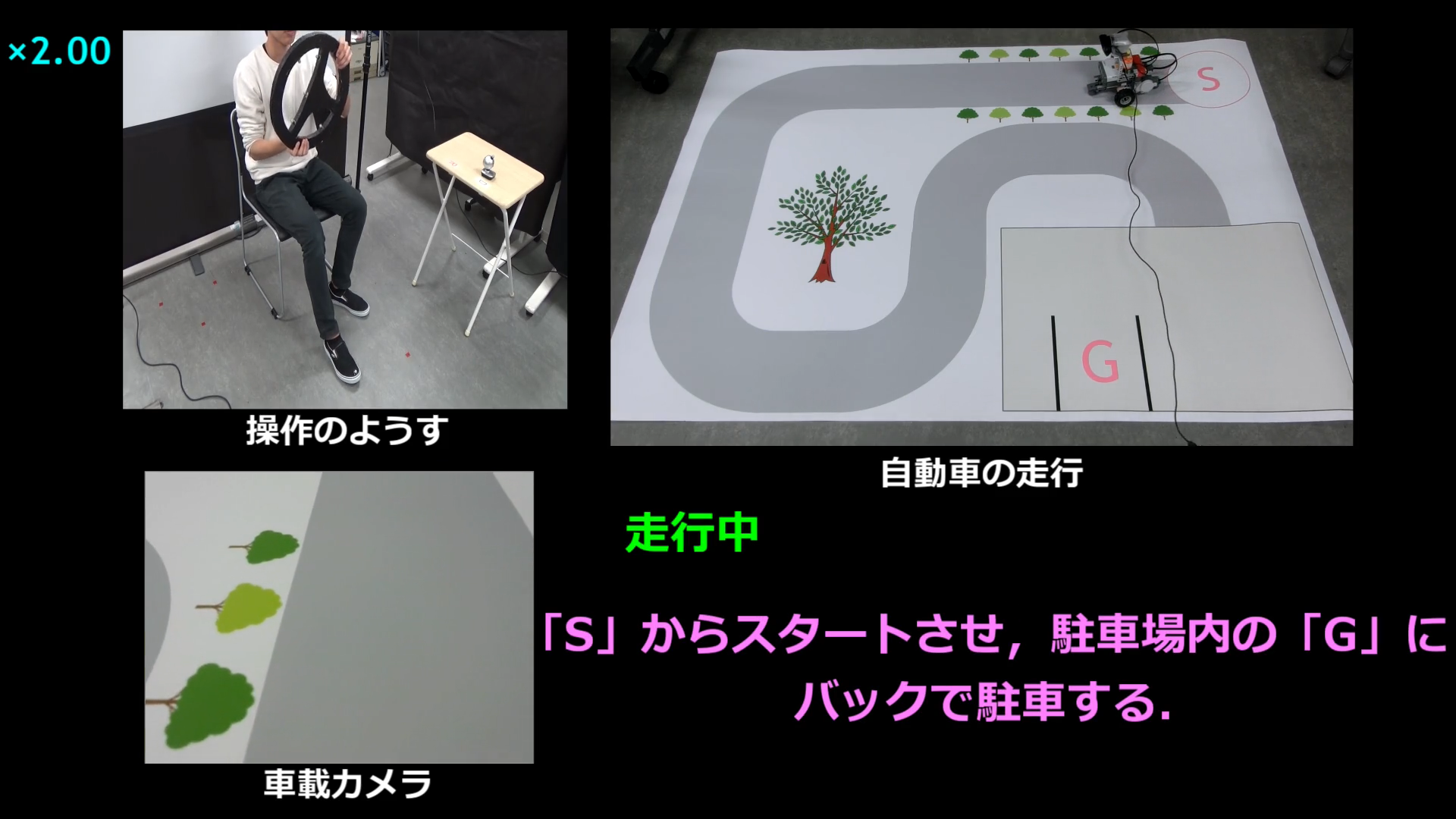

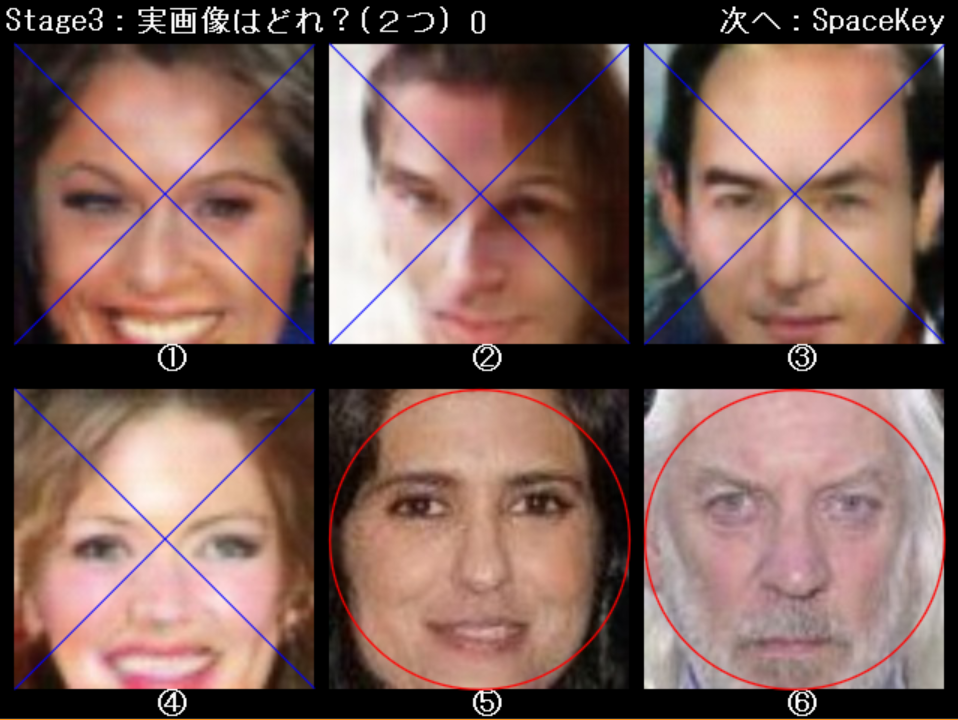

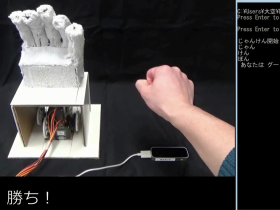

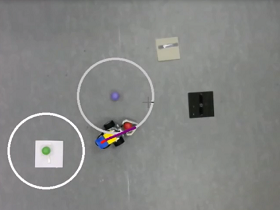

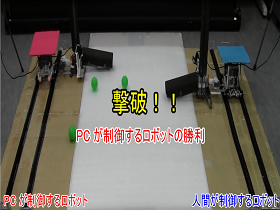

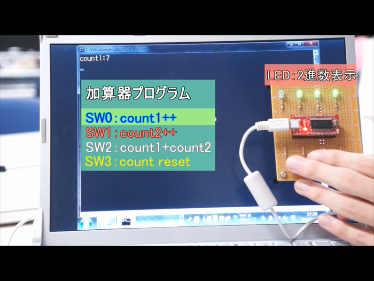

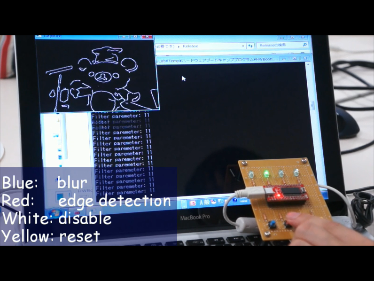

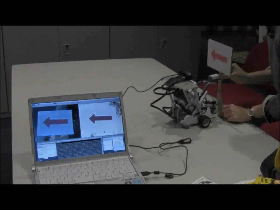

学部生による実習制作作品

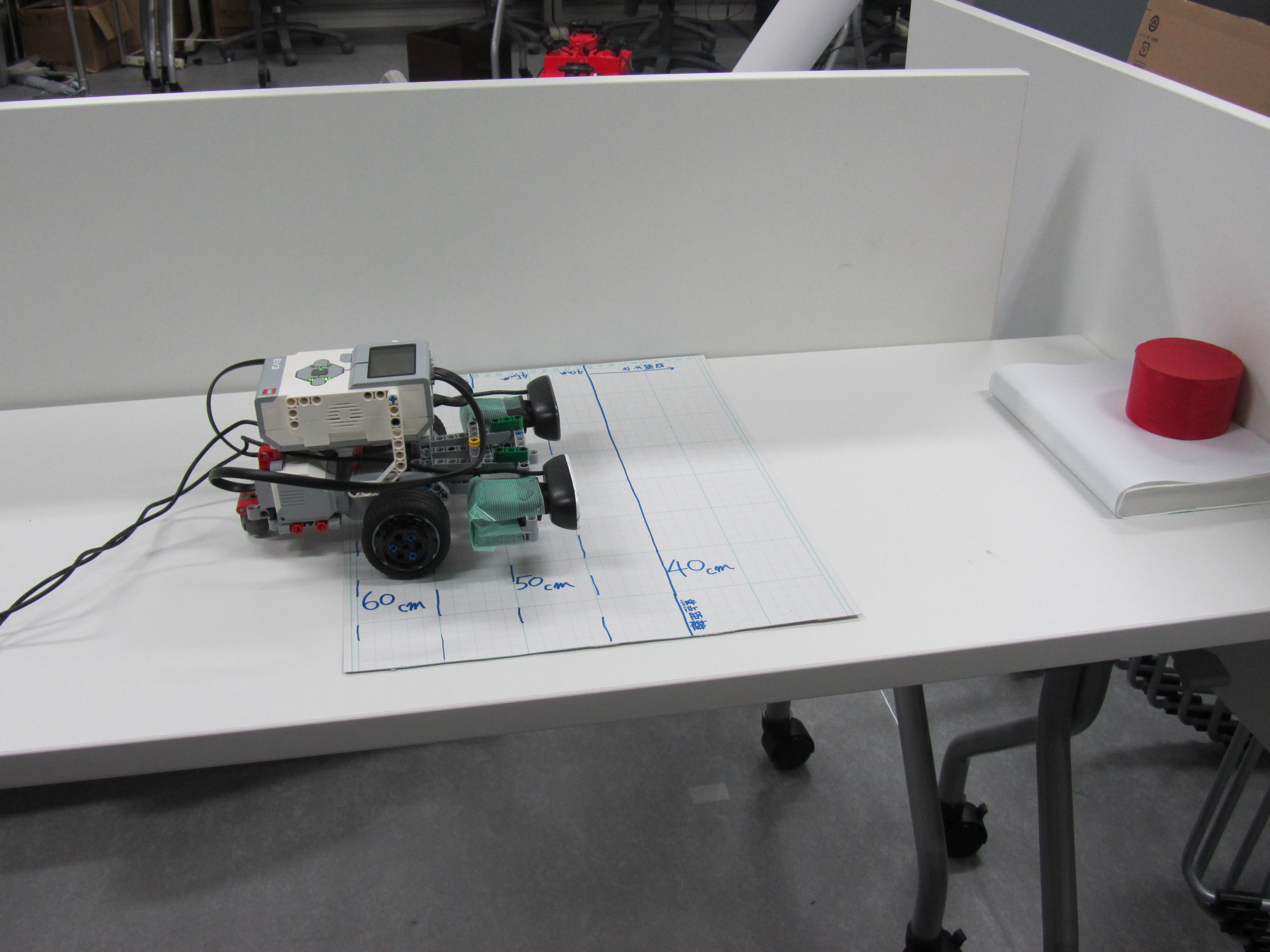

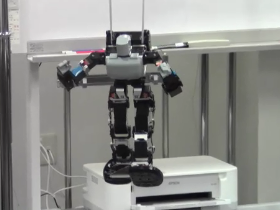

橋本研究室では,研究室に配属された学部生に対して,ロボット制御や画像処理,情報処理全般に関する 基礎および応用教育を実施しています.ここでは,学部生(主に2年生)が実習授業で制作した数々の作品 を公開しています.

2018年度

2017年度

2016年度

2015年度

2014年度

2013年度

2012年度

2011年度

2010年度

2009年度

▲Topへ

Copyright(C)2010 – Hashimoto Lab., All rights reserved